0. Abstract

Sapiens는 2D 포즈 추정, 신체 부위 세분화, 깊이 추정, 표면 법선 예측이라는 네 가지 인간 중심 비전 태스크를 위한 모델 계열이다. 이 모델은 네이티브로 1K 고해상도 추론을 지원하며, 3억 개 이상의 자연 환경에서 수집된 인간 이미지로 사전 학습된 모델을 간단히 미세 조정하여 각 태스크에 쉽게 적응할 수 있다.

동일한 계산 자원을 사용했을 때, 정제된 인간 이미지 데이터셋에 기반한 자기 지도 사전 학습은 다양한 인간 중심 태스크에서 성능을 크게 향상시킨다는 것을 관찰했다. 결과적으로, 이러한 모델은 라벨이 부족하거나 전적으로 합성된 경우에도 자연 환경 데이터에 대해 놀라운 일반화 성능을 보여준다.

간단한 모델 설계는 확장성도 제공한다. 모델의 파라미터 수를 0.3억에서 20억으로 확장함에 따라 모든 태스크에서 성능이 향상되는 것을 확인했다. Sapiens는 다양한 인간 중심 벤치마크에서 기존 기준선(baseline)을 일관되게 능가한다.

특히, Humans-5K(포즈)에서 7.6 mAP, Humans-2K(신체 부위 세분화)에서 17.1 mIoU, Hi4D(깊이)에서 22.4% 상대 RMSE, THuman2(법선)에서 53.5% 상대 각도 오차(relative angular error) 개선을 달성하며 이전 최첨단 성능을 크게 넘어섰다.

1. Introduction

최근 몇 년 동안 2D [17, 28, 50, 118] 및 3D [69, 89, 102, 109]에서 사진처럼 사실적인 인간 이미지를 생성하는 데 있어 놀라운 발전이 이루어졌다. 이러한 방법의 성공은 2D pose estimation, body-part segmentation, depth estimation, and surface normal predictio 과 같은 다양한 자산을 견고하게 추정하는 데 크게 기인한다. 그러나 이러한 자산을 견고하고 정확하게 추정하는 것은 여전히 활발한 연구 분야이며, 개별 작업의 성능을 향상시키기 위한 복잡한 시스템이 종종 더 넓은 채택을 방해하는 요소로 작용한다. 또한, 자연 환경에서 정확한 ground-truth annotation을 얻는 것은 확장하기 어렵다.

우리의 목표는 이러한 자산을 자연 환경에서 추론할 수 있는 통합된 프레임워크와 모델을 제공하여 모두를 위한 인간 중심 애플리케이션의 범위를 확장하는 것이다.

우리는 이러한 인간 중심 모델이 세 가지 기준을 충족해야 한다고 주장한다:

- generalization 모델이 다양한 환경에서 일관되게 작동하도록, 보지 못한 조건에도 견고하도록 보장한다.

- broad applicability 모델이 최소한의 수정으로 다양한 작업에 적합하도록 설계되었음을 나타낸다.

- high fidelity 모델이 정확하고 고해상도의 출력을 생성할 수 있는 능력을 의미하며, 이는 사실적인 인간 생성 작업에서 필수적이다.

- “Fidelity”는 원래 **“충실성”**이라는 뜻으로, 원본이나 실제 데이터를 얼마나 잘 유지하거나 복제했는지를 나타냄.

- • High Fidelity는 특정 작업에서:

- 세부 사항을 놓치지 않고 원본과 최대한 유사하게 재현하거나,높은 수준의 품질을 유지한다는 것을 의미함.

본 논문은 이러한 특성을 갖춘 모델(Sapiens라 지칭)을 개발하는 과정을 자세히 다룬다.

[34, 79, 91]의 통찰을 따르면, 대규모 데이터셋과 확장 가능한 모델 아키텍처를 활용하는 것이 일반화를 위한 핵심이다.

보다 광범위한 적용 가능성을 위해, 우리는 사전 학습 후 미세 조정(pretrain-then-finetune) 접근법을 채택하여 사전 학습 이후 최소한의 조정으로 특정 작업에 적응할 수 있게 한다.

이 접근법은 중요한 질문을 제기한다: 사전 학습에 가장 효과적인 데이터는 어떤 유형인가?What type of data is most effective for pretraining?

계산적 한계가 있을 때, 가능한 많은 인간 이미지를 수집하는 데 중점을 둬야 할까, 아니면 실제 세계의 변동성을 더 잘 반영하기 위해 덜 정제된 데이터를 사용하는 것이 더 나을까? 기존 방법은 다운스트림 작업의 맥락에서 사전 학습 데이터 분포를 종종 간과한다.

우리는 인간 중심 작업에서 사전 학습 데이터 분포의 영향을 연구하기 위해 3억 개의 다양한 인간 이미지를 포함하는 Humans-300M 데이터셋을 수집했다. 이 레이블 없는 이미지는 3억 개에서 20억 개의 파라미터를 가진 Vision Transformer [27] 모델 계열을 처음부터 사전 학습하는 데 사용된다.

대규모 데이터셋에서 일반적인 시각적 특징을 학습하기 위한 여러 자기 지도 학습(self-supervised learning) 방법 [5, 19, 34, 47, 48, 121] 중에서, 우리는 사전 학습의 단순성과 효율성 때문에 Masked Autoencoder(MAE) [48] 접근법을 선택했다.

MAE는 대조 학습(contrastive) 또는 다중 추론(multi-inference) 전략과 달리 단일 패스(single-pass) 추론 모델을 사용하므로 동일한 계산 자원으로 더 많은 이미지를 처리할 수 있다.

고충실도 측면에서, 기존 방법과 달리 우리는 사전 학습 입력 해상도를 1024픽셀로 증가시켰고, 이는 기존 비전 백본(vision backbone) [91] 대비 약 4배의 FLOPs 증가를 초래했다. 각 모델은 1.2조 개의 토큰으로 사전 학습되며, Table 1은 이전 접근법과의 비교를 보여준다.

human-centric tasks(2D 포즈 추정, 신체 부위 세분화, 깊이 추정, 법선 벡터 추정) [15, 101, 113, 119]에 대한 미세 조정에서, 우리는 일관된 인코더-디코더 아키텍처를 사용한다.

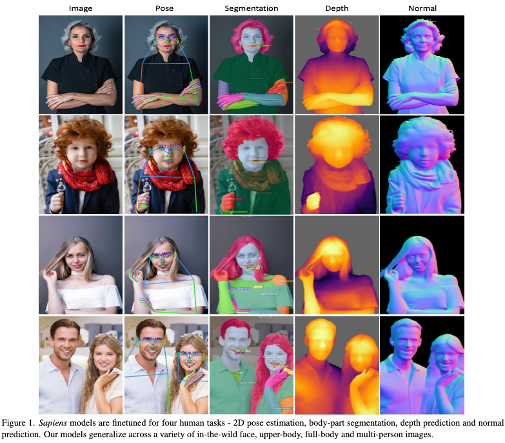

인코더는 사전 학습 가중치로 초기화되며, 디코더는 경량화된 태스크 별 헤드로 설계되며 랜덤하게 초기화된다. 이후, 두 구성 요소는 처음부터 끝까지(fine-tuning) 학습된다. 우리는 4가지 주요 작업(2D 포즈 추정, 신체 부위 세분화, 깊이 추정, 법선 벡터 추정)에 중점을 두며, Fig. 1에 이를 보여준다.

[56, 122]와 일관되게, 우리는 레이블 품질이 모델의 자연 환경(in-the-wild) 성능에 미치는 중요한 영향을 확인한다. 공용 벤치마크 데이터셋 [23, 40, 55]은 종종 잡음이 있는 레이블을 포함하며, 모델 미세 조정 동안 일관되지 않은 지도 신호를 제공한다. 동시에, 우리의 3D 인간 디지털화라는 주요 목표와 밀접하게 맞추기 위해 정밀하고 세밀한 주석을 활용하는 것이 중요하다.

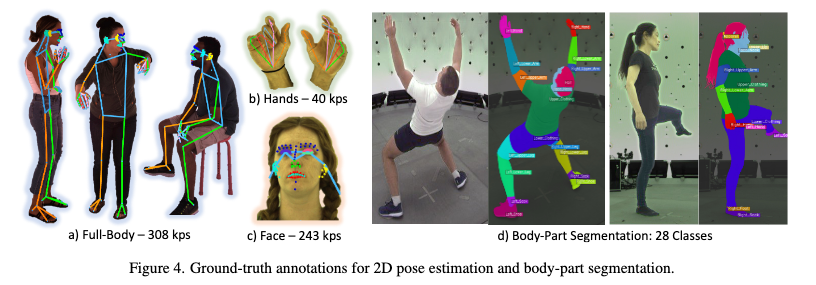

이를 위해 우리는 포즈 추정을 위한 2D 전신 키포인트의 밀도가 높은 세트를 제안하고, 기존 데이터셋 범위를 넘어서는 신체 부위 세분화를 위한 세부적인 클래스 어휘를 확장한다(Fig. 1 참조). 구체적으로, 우리는 신체, 손, 발, 표면, 얼굴을 포함한 308개의 키포인트를 포괄하는 포괄적인 세트를 도입한다. 추가적으로, 세분화 클래스 어휘를 머리카락, 혀, 치아, 상/하 입술, 상체와 같은 신체 부위를 포함하는 28개의 클래스로 확장한다.

주석의 품질과 일관성을 보장하고 높은 수준의 자동화를 위해, 우리는 멀티뷰 캡처 설정을 활용하여 포즈 및 세분화 주석을 수집한다. 우리는 또한 RenderPeople [84]의 600개의 상세한 스캔을 활용하여 고해상도 깊이 맵과 표면 법선을 생성하여, 깊이와 법선 추정을 위한 인간 중심의 합성 데이터를 활용한다. 우리는 도메인 특화 대규모 사전 학습과 제한적이지만 높은 품질의 주석을 결합한 결과가 자연 환경에서의 견고한 일반화를 이끌어낸다는 것을 보여준다. 전체적으로, 우리의 방법은 비용이 많이 들고 다양한 주석 세트를 수집하지 않고도 실제 시나리오에서 작동할 수 있는 고도로 정밀한 모델을 개발하는 효과적인 전략을 제시한다.

우리의 기여는 다음과 같이 요약된다.

• 우리는 인간 이미지를 대규모 데이터셋으로 사전 학습한 Vision Transformer 모델 계열인 Sapiens를 소개한다.

• 이 연구는 간단한 데이터 정제와 대규모 사전 학습이 동일한 계산 자원을 사용하면서도 모델의 성능을 크게 향상시킨다는 것을 보여준다.

• 고품질 또는 합성 레이블로 미세 조정된 우리의 모델은 자연 환경에서도 일반화 성능을 입증한다.

• 2D 포즈 추정, 신체 부위 세분화, 깊이 추정, 법선 벡터 예측에서 벤치마크 상 최첨단 성능을 달성하며, 인간 중심 태스크를 위한 고충실도 추론을 지원하는 최초의 1K 해상도 모델이다.

2. Related Work

우리의 연구는 자연 환경에서 수집된 인간 이미지를 대규모로 학습시키는 대형 아키텍처의 한계를 탐구한다. 이 연구는 사전 학습의 확장성, 인간 시각 태스크, 대규모 Vision Transformer 분야의 기존 연구를 기반으로 한다.

대규모 사전 학습

대규모 사전 학습 [26, 95]과 이후의 태스크 특화 미세 조정 [2, 13, 53, 96, 99, 100]이 언어 모델링 분야에서 표준 접근 방식으로 자리 잡았다. 이와 유사하게, 컴퓨터 비전 방법 [1, 4, 33, 34, 42, 79, 82, 85, 87, 120]은 점진적으로 대규모 데이터를 사전 학습에 활용하고 있다. LAION5B [90], Instagram-3.5B [77], JFT-300M [92], LVD142M [79], Visual Genome [60], YFCC100M [97]과 같은 대규모 데이터셋의 등장으로 기존 벤치마크를 넘어선 데이터 코퍼스를 탐구할 수 있게 되었다. 이 분야의 주요 연구에는 DINOv2 [79], MAWS [91], AIM [34]이 포함된다. 예를 들어, DINOv2는 LDV-142M 데이터셋 [79]에서 iBot [121] 방법을 확장해 대조 학습 기반 자가 지도 특징 학습에서 최첨단 성능을 달성했다. MAWS [91]는 MAE [48]를 수십억 개 이미지에서 확장하는 방식을 탐구했고, AIM [34]는 BERT [26]와 유사한 자기 회귀 비주얼 사전 학습의 확장 가능성을 조사했다.

이러한 기존 연구들이 주로 일반 이미지 사전 학습이나 제로샷 이미지 분류에 초점을 맞춘 것과 달리, 우리는 방대한 인간 이미지 데이터를 사전 학습에 활용한 후 인간 관련 작업에 미세 조정을 수행하는 인간 중심 접근법을 취한다.

인간 시각 태스크

대규모 3D 인간 디지털화 [8, 44, 64, 74]는 컴퓨터 비전 분야에서 중요한 목표로 남아 있다 [12]. 통제된 스튜디오 환경 [3, 59, 63, 69, 70, 76, 89]에서 상당한 진전이 있었지만, 이러한 방법을 비제약 환경으로 확장하는 데 여전히 어려움이 존재한다 [29]. 이러한 도전 과제를 해결하기 위해, 키포인트 추정 [21, 35, 46, 51, 57, 78, 80, 93, 106], 신체 부위 세분화 [36, 40, 41, 75, 104, 105], 깊이 추정 [9, 10, 32, 43, 52, 66, 83, 113], 표면 법선 예측 [6, 7, 31, 39, 62, 88, 101, 108]과 같은 여러 기본 태스크를 수행할 수 있는 다재다능한 모델 개발이 중요하다. 본 연구는 이러한 인간 중심 태스크를 자연 환경에서도 일반화할 수 있는 모델 개발을 목표로 한다.

아키텍처 확장

현재 가장 큰 공개 언어 모델은 100B 이상의 파라미터를 포함하지만 [49], 일반적으로 사용되는 언어 모델 [94, 100]은 약 7B 파라미터를 포함한다. 반면 Vision Transformer(ViT) [27]는 유사한 아키텍처를 공유함에도 불구하고 이 정도로 확장되지 못했다. ViT-4B [20]와 ViT-22B [25]와 같은 시도는 있었지만, 일반적으로 사용되는 비전 백본은 300M~600M 파라미터 사이에서 작동하며, 주로 224픽셀 해상도에서 사전 학습된다. 또한 DiT [81]과 같은 기존 Transformer 기반 이미지 생성 모델은 700M 미만의 파라미터를 사용하며 매우 압축된 잠재 공간에서 작동한다.

이 격차를 해결하기 위해, 우리는 수백만 개의 인간 이미지를 사용해 1024픽셀 이미지 해상도로 네이티브 사전 학습된 대규모 고해상도 ViT 모델인 Sapiens를 소개한다.

3. Method

3.1. Humans-300M Dataset

우리는 약 10억 개의 자연 환경 이미지로 구성된 대규모 독점 데이터셋을 사전 학습에 사용하며, 오로지 인간 이미지를 중심으로 한다.

전처리 과정에서 워터마크, 텍스트, 예술적 묘사 또는 비자연적 요소를 포함한 이미지를 제거했다.

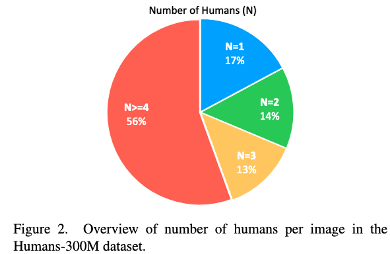

이후, off-the-shelf Bounding Box 검출기 [103]를 사용해 0.9 이상의 검출 점수를 가진 이미지와 Bounding Box 크기가 300픽셀 이상인 이미지만 선택했다. Fig. 2는 데이터셋에서 이미지당 인물 수의 분포를 보여주며, 2억 4800만 장 이상의 이미지가 다중 인물을 포함한다.

3.2. Pretraining

우리는 MAE [48] 접근법을 따라 사전 학습을 수행했다. 모델은 입력된 일부 이미지만으로 원래 인간 이미지를 복원하도록 학습된다. 모든 Autoencoder와 마찬가지로, 인코더는 보이는 이미지를 잠재 표현으로 매핑하고 디코더는 이 잠재 표현을 기반으로 원래 이미지를 복원한다. 사전 학습 데이터셋은 단일 및 다중 인물 이미지를 포함하며, 모든 이미지는 고정된 정사각형 비율로 크기 조정된다.

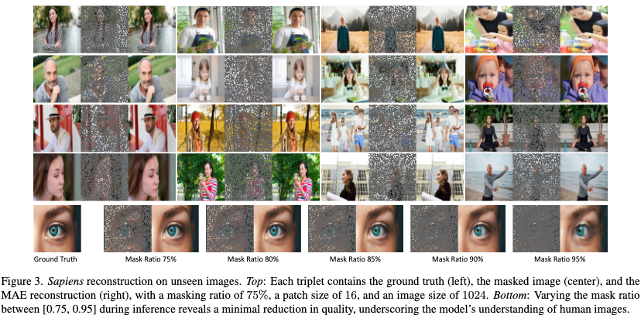

ViT [27]와 유사하게 이미지는 고정 크기의 비중첩 패치로 나뉘며, 일부 패치는 무작위로 선택되어 마스킹되고 나머지만 보인다. 마스킹 비율은 학습 동안 고정된다. Fig. 3(상단)은 보지 못한 인간 이미지에 대한 사전 학습된 모델의 복원을 보여준다.

우리 모델은 크기, 자르기, 대상의 연령 및 인종, 인물 수와 같은 다양한 이미지 특성에 대해 일반화 성능을 보인다.

각 패치 토큰은 표준 ViT에서 0.4%의 이미지 영역을 처리하는 것과 비교해 0.02%만 처리하며, 이는 모델 간 세밀한 패치 간 추론을 가능하게 한다. Fig. 3(하단)은 마스킹 비율이 95%로 증가하더라도, 보류된 샘플에서 인간 해부학에 대한 그럴듯한 복원을 달성했음을 보여준다.

3.3. 2D Pose Estimation

우리는 Top-Down 접근 방식을 따라 입력 이미지 I ∈ RH×W ×3 에서 키포인트의 위치를 탐지하는 것을 목표로 한다.

대부분의 방법은 이 문제를 히트맵 예측으로 간주하며, K개의 히트맵 각각이 해당 키포인트가 특정 공간 위치에 있을 확률을 나타낸다.

ViT 구조를 확장한 포즈 추정기를 사용하며, 308개의 키포인트를 포함한 고해상도 데이터셋을 활용한다.

3.4. Body-Part Segmentation

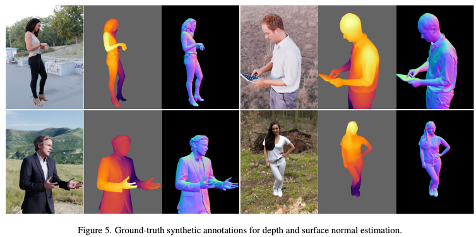

일반적으로 Human Parsing으로 알려진 Body-Part Segmentation는 입력 이미지 I의 픽셀을 C개의 클래스 중 하나로 분류하는 작업이다. 대부분의 방법 [40]은 이 문제를 각 픽셀별 클래스 확률을 추정해 확률 맵 pˆ ∈ RH×W ×C, pˆ = S(I) 를 생성하는 것으로 변환하며, 여기서 S 는 세분화 모델을 나타낸다. 앞서 설명했듯이, 우리는 에 대해 동일한 인코더-디코더 아키텍처와 초기화 방식을 사용한다. 는 실제 확률 맵 와 예측 확률 맵 사이의 가중 교차 엔트로피 손실(Weighted Cross-Entropy Loss), 를 최소화하도록 미세 조정된다.

는 두 가지 세분화 어휘에 대해 미세 조정된다: 20개 클래스로 구성된 표준 세트 [40]와 C = 28개의 더 큰 vocabulary로 구성된 새로운 세트이다(Fig. 4 (Right) 참고). 우리의 제안된 어휘는 기존 데이터셋을 중요한 방식으로 확장한다.

이는 팔다리의 상/하 반쪽을 구분하고, 상/하 입술, 치아, 혀와 같은 더 세부적인 분류를 포함한다.

이를 위해, 우리는 이 vocabulary를 사용해 100K개의 이미지를 4K 해상도로 수작업 주석 처리하였다.

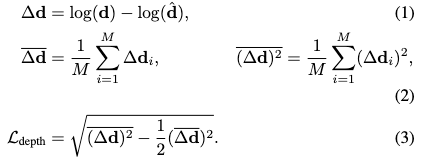

3.5. Depth Estimation

깊이 추정에서는 세분화에서 사용한 아키텍처를 채택하되, 디코더 출력 채널을 회귀(regression)를 위해 1로 설정하는 수정이 추가된다.

M은 이미지 내의 사람 픽셀 수를 나타낸다.

**상대적 깊이 추정(Relative Depth Estimation)**을 위해, 를 이미지 내 최대 및 최소 깊이를 사용하여 [0, 1] 범위로 정규화한다.

깊이 추정기 의 손실 L_depth loss는 다음과 같이 정의된다:

우리는 600개의 고해상도 photogrammetry human scans을 사용해 500,000개의 합성 이미지를 생성하였다(Fig. 5 참고). 이는 높은 fidelity 의 robust monocular depth estimation model을 확보하기 위한 것이다. 랜덤 배경은 100개의 HDRI 환경 맵 컬렉션에서 선택되었으며, 가상 카메라는 장면 내에서 focal length, rotation, translation을 랜덤하게 조정하여 4K 해상도의 이미지와 그에 따른 실제 깊이 맵을 캡처한다.

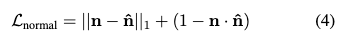

3.6. Surface Normal Estimation

이전 작업과 유사하게, normal estimator N 표면 법선 추정기 의 디코더 출력 채널은 각 픽셀의 법선 벡터의 구성 요소에 해당하는 3으로 설정된다. 생성된 synthetic data는 face normal estimation을 위한 지도 신호로도 사용된다. 이미지를 I , 실제 법선 맵을 nˆ = N (I), 예측 법선 맵을 로 나타낸다.

depth과 유사하게, loss L_normal 은 이미지 내의 human pixels에 대해서만 계산되며 다음과 같이 정의된다:

법선(Normal)이란? 법선은 특정 표면에서 수직으로 나오는 벡터를 말합니다. 이 벡터는 그 표면의 기울기와 방향을 나타내며, 주로 조명 계산에서 사용됩니다. 각 정점 또는 면의 법선을 통해 3D 엔진은 그 표면이 어떻게 빛을 반사하는지 결정합니다.

Face Normal Estimation (얼굴 법선 추정)

Face Normal Estimation은 얼굴 표면의 각 지점에서 **법선 벡터(Normal Vector)**를 추정하는 작업을 말한다. 법선 벡터는 표면의 기울기와 방향을 나타내며, 3D 얼굴 모델링, 조명 계산, 그리고 그래픽 및 비전 태스크에서 중요한 정보를 제공한다.

• 법선(Normal):

• 3D 공간에서 어떤 표면의 특정 지점에서 **직각(수직)**으로 뻗어나가는 벡터를 뜻한다.

• 표면이 어디로 향하고 있는지 나타낸다.

• 표면 법선(Surface Normal):

• 법선 벡터 중에서도 표면의 기울기와 방향을 나타내는 벡터를 말한다.

• 표면의 특성과 형태를 설명하며, 빛 반사, 그림자 생성 등 그래픽 렌더링과 물리적 시뮬레이션에 사용된다.

4. Experiments

이 섹션에서는 구현 세부사항을 개괄한 뒤, pose estimation, part segmentation, depth estimation, and normal estimation의 네 가지 작업에 대해 종합적인 벤치마킹을 수행하였다.

4.1. Implementation Details

가장 큰 모델인 Sapiens-2B는 1024개의 A100 GPU를 사용해 PyTorch로 18일 동안 사전 학습하였다.

모든 실험에서 AdamW [73] 옵티마이저를 사용하였다. 학습 스케줄은 짧은 선형 웜업(linear warm-up) 뒤에 사전 학습을 위한 **코사인 감소(cosine annealing)**와 미세 조정을 위한 **선형 감소(linear decay)**로 구성된다. 모든 모델은 1024 × 1024 해상도에서 패치 크기 16으로 처음부터 사전 학습되었다. 미세 조정을 위해 입력 이미지는 4:3 비율로 크기 조정되어 1024 × 768로 변경되었다. 표준 데이터 증강 기법(자르기, 스케일링, 뒤집기, 사진 왜곡)이 사용되었다. 세분화, 깊이, 법선 예측 작업에는 비인간 COCO [67] 이미지에서 랜덤 배경이 추가되었다.

특히, 일반화를 유지하기 위해 **차등 학습률(differential learning rates)**을 사용하였다. 초기 레이어에는 낮은 학습률을, 이후 레이어에는 점차 높은 학습률을 적용한다. 레이어별 학습률 감소율은 0.85로 설정되었고, 인코더의 가중치 감소(weight decay)는 0.1이다. Sapiens의 설계 사양은 Table 2에 자세히 나와 있다. [34, 100]을 따라 모델 확장은 깊이보다는 폭을 우선시하였다. Sapiens-0.3B 모델은 전통적인 ViT-Large와 구조적으로 유사하지만, 더 높은 해상도로 인해 FLOPs가 20배 증가하였다.

4.2. 2D Pose Estimation

Sapiens는 얼굴, 신체, 발, 손 포즈 추정()을 위해 고충실도 주석으로 미세 조정되었다. 학습에는 100만 개 이미지의 학습 세트를, 평가에는 Humans5K로 명명된 5천 개 이미지의 테스트 세트를 사용하였다. 평가 방식은 Top-Down [111]으로, 사전 학습된 검출기 [37]를 사용해 바운딩 박스를 추출한 뒤 단일 인간 포즈 추정을 수행하였다.

Table 3은 전체 신체 포즈 추정에 대해 기존 방법과 비교한 결과를 보여준다. 모든 방법은 COCOWholeBody [55]의 133 키포인트 어휘와 우리의 308 키포인트 어휘 간 114개의 공통 키포인트에 대해 평가되었다. Sapiens-0.6B는 DWPose-l [115]을 +2.8 AP로 초과하며 현재 최첨단 성능을 능가한다. 기존의 복잡한 학생-교사 프레임워크를 사용하는 DWPose [115]와 달리, Sapiens는 일반적인 인코더-디코더 아키텍처와 대규모 인간 중심 사전 학습을 채택하였다.

4.4. Depth Estimation

깊이 추정을 위해 THuman2.0 [117]와 Hi4D [116] 데이터셋을 사용해 모델을 평가한다. THuman2.0은 고품질의 인간 스캔 526개로 구성되며, 이를 가상 카메라를 활용해 얼굴, 상체, 전체 신체라는 세 가지 이미지 세트로 변환하여 테스트에 사용한다. 총 1578장의 이미지를 통해 단일 인간 이미지에서 다양한 스케일에 걸쳐 모델 성능을 평가할 수 있다. 반면, Hi4D 데이터셋은 인간 간 상호작용이 포함된 다중 인간 시나리오를 중점으로 한다. 우리는 Hi4D의 쌍(pair) 28, 32, 37에서 각기 다른 여섯 명의 피사체를 포함한 시퀀스를 선택하였으며, 카메라 4로 촬영된 총 1195장의 다중 인간 실제 이미지를 테스트에 사용한다.

우리는 MiDaSv3.1 [11]이 제안한 상대적 깊이 평가 프로토콜을 따르며, AbsRel 및 과 같은 표준 지표를 보고한다. 추가적으로, 인간 장면의 미세한 깊이 변화를 더 잘 반영하기 위해 RMSE를 주요 지표로 사용한다. Table 5는 우리의 모델을 기존 단안 깊이 추정 방법과 비교한 결과를 보여준다. 합성 데이터만으로 미세 조정된 Sapiens-2B는 모든 단일 인간 스케일과 다중 인간 시나리오에서 기존 최첨단 모델을 능가한다. Hi4D 이미지에서 가장 우수한 Depth-Anything 모델 대비 RMSE가 20% 감소함을 관찰할 수 있다. 중요한 점은 기존 베이스라인 모델이 다양한 장면을 학습한 반면, Sapiens는 인간 중심 깊이 추정에 특화되었다는 점이다. Fig. 8은 Sapiens-1B와 Depth-Anything-L 간 깊이 추정의 질적 비교를 보여준다. 공정한 비교를 위해, 예측된 깊이는 베이스라인 시각화에서 인간 마스크를 사용해 다시 정규화되었다.

4.5. Surface Normal Estimation

표면 법선 평가를 위한 데이터셋은 깊이 추정에서 사용한 데이터셋과 동일하다. [30]을 따라 평균 및 중앙값 각도 오차(mean and median angular error), 그리고 내에 있는 픽셀의 비율을 보고한다. Table 6은 우리의 모델과 기존 인간 중심 표면 법선 추정기를 비교한 결과를 보여준다. 모든 모델이 기존 방법을 크게 능가하며, Sapiens-2B는 THuman2.0(단일 인간) 및 Hi4D(다중 인간) 데이터셋에서 약 의 평균 오차를 달성한다. Fig. 9는 Sapiens-1B와 PIFuHD [89], ECON [108] 간 표면 법선 추정의 질적 비교를 보여준다. PIFuHD는 우리의 3D 스캔 세트와 동일한 데이터를 사용해 학습되었고, ECON은 우리의 데이터보다 더 큰 4000개의 3D 스캔 데이터로 학습되었다.

4.6. Discussion

사전 학습 데이터 소스의 중요성

특징 품질은 사전 학습 데이터 품질과 밀접하게 연관되어 있다. 우리는 인간 중심 태스크에 대한 다양한 데이터 소스에서 Sapiens-0.3B를 동일한 학습 일정과 반복 횟수로 사전 학습하여, 사전 학습 데이터 소스의 중요성을 평가한다. 각 태스크에 대해 모델을 미세 조정하고, 초기 체크포인트를 선택하여 평가하는데, 이는 초기 단계의 미세 조정이 모델의 일반화 능력을 더 잘 반영한다고 보기 때문이다.

우리는 Sapiens를 사용해 일반 이미지를 활용한 대규모 사전 학습(인간 이미지를 포함할 수 있음)과 순전히 인간 이미지만을 사용한 사전 학습의 영향을 조사한다. 10억 개의 이미지 코퍼스에서 1억 개와 3억 개의 일반 이미지를 무작위로 선택해 각각 General-100M과 General-300M 데이터셋을 생성한다. Table 7은 사전 학습 결과를 비교한 내용을 보여준다. 우리는 Humans-5K에서 포즈 추정을 위한 mAP, Humans-2K에서 세분화를 위한 mIoU, THuman2.0에서 깊이를 위한 RMSE, Hi4D에서 법선 추정을 위한 평균 각도 오차를 보고한다. [112]의 연구와 일치하게, Human-300M으로 사전 학습할 경우 모든 지표에서 성능이 뛰어나며, 제한된 계산 자원 내에서 인간 중심 사전 학습의 이점을 강조한다.

우리는 사전 학습 중 관찰된 고유 인간 이미지 수가 법선 추정 성능에 미치는 영향을 연구하며, 이내의 비율을 보고한다. 동일한 조건에서 Sapiens-0.3B를 사전 학습 및 미세 조정하였고, Fig. 10은 사전 학습 데이터 크기가 증가함에 따라 성능이 포화 없이 꾸준히 개선되는 것을 보여준다. 요약하면, 사전 학습 중 관찰된 인간 이미지의 다양성은 다운스트림 태스크로의 일반화 성능 향상과 직접적으로 연관된다.

제로샷 일반화

우리의 모델은 다양한 설정에서 폭넓은 일반화 성능을 보인다. 예를 들어, 세분화에서는 단일 인간 이미지, 제한된 대상 다양성, 최소한의 배경 변화, 그리고 3인칭 뷰로만 미세 조정되었음에도 불구하고(Fig. 4 참고), 대규모 사전 학습 덕분에 피사체 수, 연령대 변화, 자아 관점 뷰(egocentric views) 등에서도 일반화 성능을 발휘한다(Fig. 11 참고). 이러한 관찰은 다른 태스크에도 유사하게 적용된다.

제한점

우리의 모델이 대체로 우수한 성능을 보이지만, 완벽하지는 않다. 복잡하거나 드문 포즈, 군중 밀집, 심한 가림 현상이 있는 인간 이미지는 여전히 도전 과제로 남아 있다(부록 참조). 이러한 문제를 완화하기 위해 데이터 증강 및 탐지-자르기 전략을 사용할 수 있지만, 우리는 우리의 모델을 인간 참여형 대규모 실세계 감독 도구로 활용하여 차세대 인간 비전 모델 개발의 기반으로 삼고자 한다.

5. Conclusion

Sapiens는 인간 중심 비전 모델을 **파운데이션 모델(foundation model)**로 끌어올리는 중요한 진전을 나타낸다. 우리의 모델은 다양한 인간 중심 태스크에서 강력한 일반화 성능을 보여준다. 우리는 모델의 최첨단 성능을 다음 세 가지 요인에 기인한다고 본다:

1. 인간 이해에 특화된 대규모 정제 데이터셋에서의 사전 학습,

2. 확장된 고해상도 및 고용량 Vision Transformer 백본,

3. 증강된 스튜디오 및 합성 데이터에서의 고품질 주석.

이 모델들은 다양한 다운스트림 태스크를 위한 핵심 빌딩 블록이 될 수 있으며, 더 넓은 커뮤니티에 고품질 비전 백본을 제공할 수 있을 것으로 본다. 향후 연구 방향으로는 Sapiens를 3D 및 멀티모달 데이터셋으로 확장하는 것이 유망하다.

Sapiens 모델에서 사용된 주요 평가지표들

1. Humans-5K: mAP (Mean Average Precision)

(1) 개념

• mAP (Mean Average Precision):

• 예측된 Keypoint(자세 포인트)가 정확히 실제 Keypoint와 일치하는 비율을 나타냄.

• 2D 포즈 추정(2D Pose Estimation) 성능을 평가하는 데 사용.

(2) 계산 방법

1. Precision (정밀도):

• 모델이 예측한 Keypoint 중 실제로 올바른 Keypoint의 비율.

2. AP (Average Precision):

• 정밀도-재현율(Recall) 곡선의 아래 영역(AUC)을 계산.

3. mAP (Mean AP):

• 여러 Keypoint 클래스(예: 신체 부위별)에서의 AP를 평균.

(3) Humans-5K에서의 역할

• Humans-5K 데이터셋의 포즈 추정 성능을 평가하기 위해 mAP를 사용.

• 모델이 얼마나 정밀하게 신체 포인트를 예측했는지 확인.

2. Humans-2K: mIoU (Mean Intersection over Union)

(1) 개념

• mIoU (Mean Intersection over Union):

• Segmentation(분할) 작업에서 예측된 영역과 실제 영역이 겹치는 정도를 나타냄.

• 클래스별 IoU를 계산한 후 평균을 취함.

(2) 계산 방법

• IoU = \(\frac{\text{예측 영역} \cap \text{실제 영역}}{\text{예측 영역} \cup \text{실제 영역}} \)

• \(\cap\): 예측 영역과 실제 영역의 교집합.

• \(\cup\) : 예측 영역과 실제 영역의 합집합.

• mIoU는 모든 클래스에서의 IoU 평균값.

(3) Humans-2K에서의 역할

• Humans-2K 데이터셋의 세분화(Segmentation) 성능을 평가.

• 신체 부위를 얼마나 정확히 분할했는지 측정.

3. THuman2.0: RMSE (Root Mean Square Error)

(1) 개념

• RMSE (Root Mean Square Error):

\(RMSE = \sqrt{\frac{1}{N} \sum_{i=1}^{N} (d_i - \hat{d}_i)^2}\)

• d_i: 실제 깊이 값.

• \hat{d}_i: 예측 깊이 값.

• N: 총 픽셀 수.

• 예측된 깊이 값(Depth)과 실제 깊이 값 간의 평균적인 오차를 나타냄.

• 오차의 제곱 평균을 계산한 후 제곱근을 취해 값이 큰 오차에 더 민감하게 반응.

THuman2.0에서의 역할

• 다양한 스케일(얼굴, 상반신, 전신)에서의 깊이 예측 성능을 평가.

• RMSE가 낮을수록 깊이를 정확히 예측했음을 의미.

4. Hi4D: Mean Angular Error

(1) 개념

• Mean Angular Error (평균 각도 오차):

• 예측된 표면 법선(Surface Normal) 벡터와 실제 법선 벡터 간의 평균적인 각도 차이.

• 표면이 얼마나 정확히 기울어져 있는지를 평가.

(2) 계산 방법

• 두 벡터 (실제 법선)과 (예측 법선) 사이의 각도 를 계산:

\(\cos \theta = \frac{n \cdot \hat{n}}{\|n\| \|\hat{n}\|}\)

• Mean Angular Error는 모든 픽셀에 대한 값을 평균화.

(3) Hi4D에서의 역할

• 복잡한 다인 환경에서 표면 법선을 얼마나 정확히 예측했는지 평가.

• 법선이 정밀할수록 더 현실적인 3D 렌더링이나 깊이 정보를 제공.

5. 요약: 각 평가지표의 특징

데이터셋 평가지표 설명

Humans-5K mAP 포즈 추정(2D Keypoint 예측)의 정밀도와 정확도를 평가.

Humans-2K mIoU 분할(Segmentation)에서 예측된 영역과 실제 영역의 겹침 정도를 평가.

THuman2.0 RMSE 깊이 예측(Depth Estimation)에서 예측값과 실제값의 평균 오차를 계산.

Hi4D Mean Angular Error 표면 법선 예측(Surface Normal Estimation)에서 각도 오차를 측정하여 표면의 기울기 정확도를 평가.

6. Sapiens 모델의 성능 요약

• Sapiens 모델은 각 데이터셋과 지표에서 기존 SOTA 성능을 능가:

• Humans-5K: 포즈 추정에서 높은 mAP.

• Humans-2K: 분할 작업에서 높은 mIoU.

• THuman2.0: 깊이 예측에서 낮은 RMSE.

• Hi4D: 표면 법선 예측에서 낮은 Mean Angular Error.

이 지표들은 모델이 인간 중심 비전 작업에서 얼마나 세밀하고 정확한 결과를 제공하는지 평가하는 데 사용됩니다. 😊