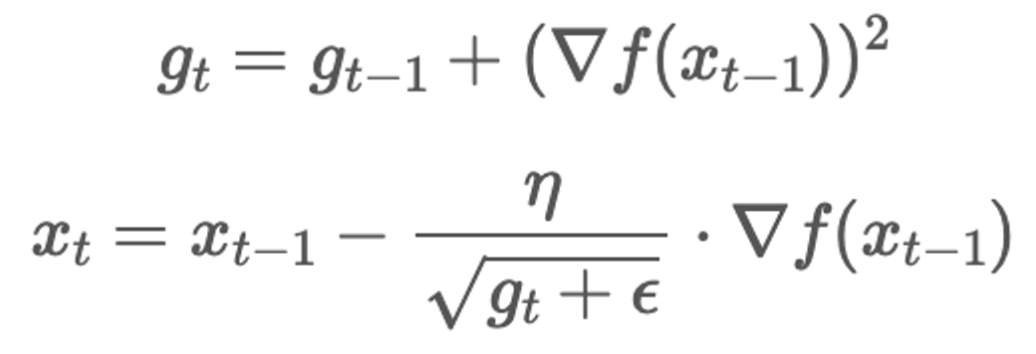

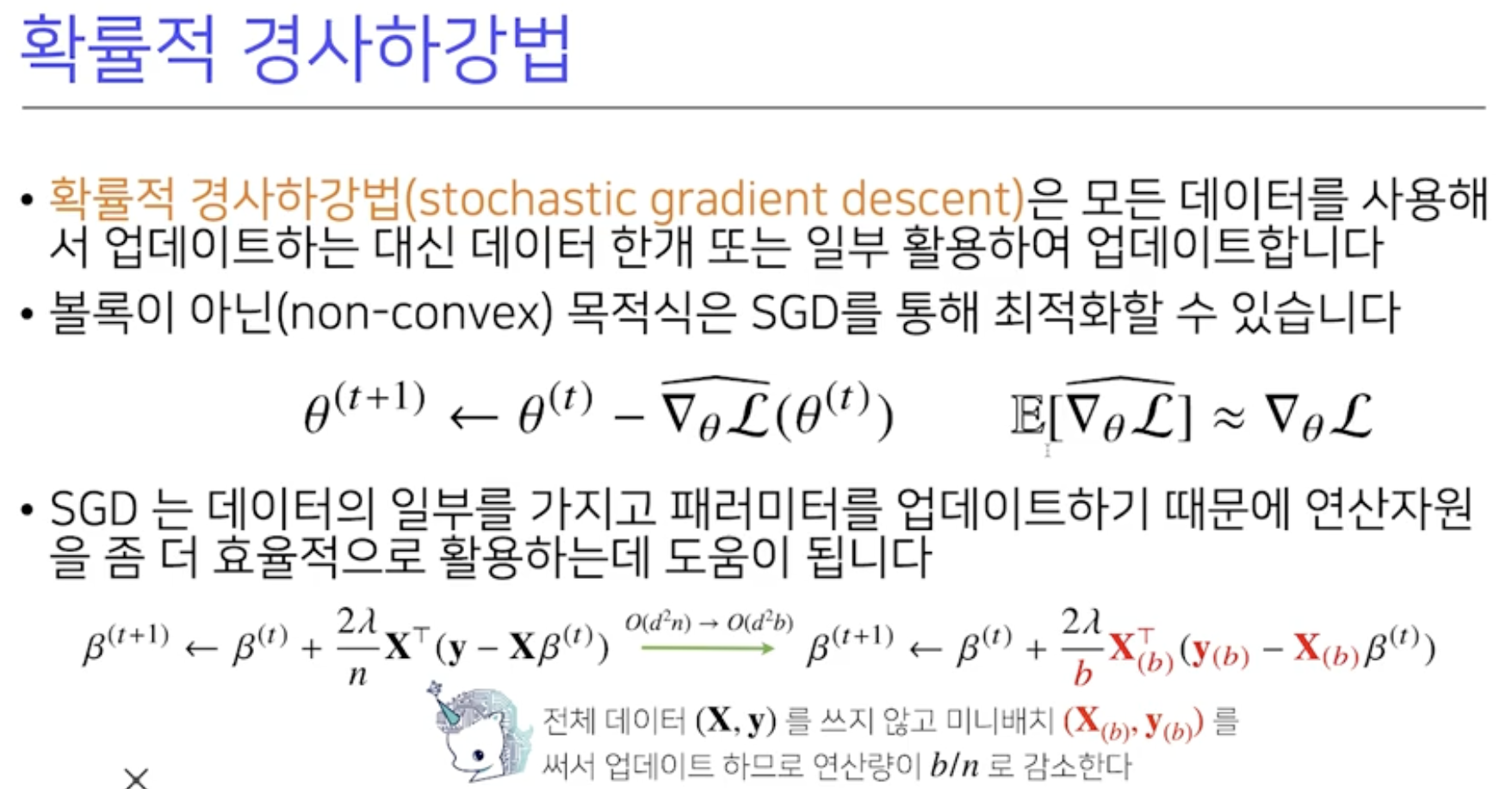

경사하강법(Gradient Descent) :손실 함수의 기울기(gradient)를 사용하여 모델의 가중치를 업데이트하는 최적화 알고리즘가중치가 손실 함수의 값을 최소화하는 방향으로 이동시키는 것기울기 계산 (Gradient Calculation): 손실 함수 L(θ)의 현재 가중치 θ에 대한 기울기 ∇L(θ)를 계산가중치 업데이트 (Weight Update): 기울기에 학습률(learning rate) η을 곱한 값을 현재 가중치에서 뺀다.θ←θ−η∇L(θ)업데이트된 가중치를 사용하여 다시 손실 함수의 기울기를 계산, 이 과정을 반복. 모델의 가중치는 점차 손실 함수를 최소화하는 방향으로 조정됨.학습률이 너무 크면 최적점에 도달하지 못하고 발산/진동 할 수 있으며, 너무 작으면 수렴 속도가 느려질 수 ..