keyword Diffusion Models, Image, Adversarial Attack

0. Abstract

최근 diffusion models의 발전은 image generation에 혁명을 일으켰지만, 예술 작품 복제나 deepfakes 생성과 같은 오용의 위험을 제기함.

기존의 image protection methods는 효과적이지만, protection efficacy, invisibility, latency 사이의 균형을 맞추는 데 어려움을 겪어 실용적인 사용을 제한함.

우리는 latency를 줄이기 위해 perturbation pre-training을 도입하고, performance degradation을 최소화하기 위해 input images에 동적으로 적응하는 mixture-of-perturbations approach를 제안함.

우리의 새로운 training strategy는 여러 VAE feature spaces에 걸쳐 protection loss를 계산하며, inference 시 adaptive targeted protection은 robustness와 invisibility를 향상시킴.

실험 결과, 향상된 invisibility와 대폭 감소된 inference time으로 비슷한 protection performance를 보임.

Code와 demo는 https://webtoon.github.io/impasto 에서 확인할 수 있음.

1. Introduction

대규모 diffusion models [16, 41, 43, 50]은 image synthesis task 영역에서 놀라운 성공을 거두었으며, 우리가 디지털 이미지를 만들고 조작하는 방식에 혁명을 일으켰음 [18, 21, 34, 40, 57].

최근 등장한 personalization techniques를 채택함으로써, 이제는 개인의 고유한 스타일로 이미지를 생성할 수 있는 diffusion models를 개발하는 것이 가능해졌음 [2, 11, 24, 44, 49].

그러나 이러한 모델들을 매우 가치있게 만드는 바로 그 능력들이 상당한 위험을 초래하기도 함.

Diffusion models는 악의적인 사용자가 개인의 예술 작품을 동의 없이 복제하여 그들의 창작물을 쉽게 훔칠 수 있게 함 [48].

더욱이, diffusion models는 얼굴과 사물을 모방하는 데 매우 능숙함 [24, 44]. 이러한 숙련도는 양성적인 응용에만 국한되지 않고 deepfakes나 fake news를 만드는 데까지 확장될 수 있음.

이러한 기술들이 대중의 신뢰를 훼손하고, 정치적 담론을 왜곡하며, 개인의 사생활을 침해하는 데 사용될 수 있기 때문에 사회적 해악에 대한 시사점은 심각함.

Diffusion models로부터 이미지를 보호하려는 현재의 노력은 adversarial perturbation [12]을 통해 발전해왔음. 주어진 이미지에 perturbations를 도입함으로써, 보호된 이미지가 diffusion-based personalization methods에 저항하도록 만들어 diffusion model이 왜곡된 결과물을 생성하게 함.

기존의 방법들은 주로 두 가지 접근 방식에 의존함:

- VAE encoder 내에서 보호된 이미지와 사전 정의된 target image의 latent features 사이의 거리를 최소화하는 방법(예: PhotoGuard [46] 및 Glaze [48])

- 또는 noise prediction network를 속이는 방법(예: AdvDM [28] 및 Anti-DB [51]).

수많은 발전에도 불구하고, 현재의 모든 frameworks는 근본적으로 보호가 요청될 때 inference [33] 중에 perturbations를 최적화하는 접근 방식에서 시작하므로, 이러한 방법들이 많은 실제 응용 프로그램에서 사용될 수 있는지에 대한 실용성에 의문을 제기함.

Protection framework가 실용적인 해결책이 되려면 다음 조건들이 충족되어야 함:

- (1) Protection Efficacy: 당연히, image protection method는 diffusion-based personalization에 효과적으로 대응해야 함. 많은 최근 연구들은 diffusion models의 내부 동역학을 분석하여 이 측면을 극대화하는 것을 목표로 해왔음 [56, 61].

- (2) Invisibility: 일부 연구들이 가능한 한 보이지 않도록 노력하지만, adversarial perturbations는 필연적으로 이미지에 가시적인 흔적을 남김. 그러나, commercial services의 경우 이러한 흔적을 최소화하는 것이 중요함. 더욱이, Ahn et al. [1]이 분석한 바와 같이, mimicry를 방지하는 작업은 특히 평평한 질감의 이미지(예: cartoon 또는 illustration)에서 더 눈에 띄는 흔적을 남기는 경향이 있음. 그 중요성에도 불구하고, 소수의 연구만이 이 문제를 강조함 [1].

- (3) Latency: 모든 기존 방법들은 iterative optimization을 통해 inference 단계에서 perturbations를 업데이트함. 그러나, 이 과정은 본질적으로 시간이 많이 소요됨; 예를 들어 512px 이미지를 보호하는 데 CPU에서는 최대 5-120분, 고사양 A100 GPU에서도 7-200초가 걸릴 수 있음. 현재의 protection methods에 필요한 긴 시간은 일반 사용자가 image protection을 활용하는 것을 막는 상당한 장벽이 되며, 이로 인해 사용자들은 여전히 generative models의 오용 위험에 노출됨. 결과적으로, 이 기술을 대중화하기 위해서는 덜 강력한 장치에서도 효과적으로 작동할 수 있는 protection framework를 개발하는 것이 중요함. 불행히도, image protection task의 광범위한 진전에도 불구하고 latency를 줄이는 데에는 거의 초점이 맞춰지지 않았음.

- Image protection:

→ “이미지를 살짝 망쳐서, 사람 눈에는 똑같이 보이지만

→ diffusion personalization이 그 사람/작가를 따라 하지 못하게 만드는 adversarial 방어”. - Invisibility:

→ 그 perturbation이 얼마나 안 보이는지 (원본과의 perceptual 차이; DISTS로 측정). - Latency:

→ 한 장 보호하는 데 걸리는 실제 처리 시간 (CPU/GPU 기준 초 단위로 측정).

1. image protection ?

개인의 이미지(작품/얼굴 사진 등)에 아주 작은 adversarial perturbation을 미리 입혀서,

그 이미지를 가지고 Diffusion personalization(LoRA, DreamBooth, TI 등)을 해도

모델이 그 스타일/얼굴을 제대로 따라 하지 못하게 만드는 것

- 원본 이미지: xx

- 보호된 이미지: x′=x+δx' = x + \delta (여기서 δ\delta는 작은 perturbation)

요구 조건은:

- 사람 눈에는 거의 똑같이 보일 것

- 하지만 이 x′x'들을 모아서 LoRA 같은 personalization을 하면

- 생성 결과가 원래 스타일/아이덴티티를 잘 못 따라 하도록(= mimicry가 망가진 상태) 만들 것

그래서 “image protection”은,

- _classifier accuracy를 떨어뜨리려는 일반 adversarial attack_이 아니라

- _“내 이미지를 학습 데이터로 썼을 때, 나를 못 따라 하게 만드는 방어(poisoning) 기법”

이 논문에서는 이 보호 성능을 protection efficacy라고 부르면서, LoRA로 mimic한 이미지들에 대해 FID가 얼마나 높아지는지로 측정. (FID ↑ = 보호 잘 됨)

2. Invisibility?

보호용 perturbation이 사람 눈에 얼마나 안 보이느냐, 보호된 이미지 x'가 원본 x랑 얼마나 시각적으로 비슷하냐

- perturbation 세게 넣으면 보호 성능(FID)은 올라가지만

- 이미지가 지저분해 보이거나 텍스처 깨짐 → invisibility가 나빠짐

그래서 논문에서는 이미지 품질/유사도 지표 DISTS를 invisibility metric으로 써:

- DISTS(x, x′) 작을수록 → 두 이미지가 perceptual하게 비슷 → invisibility 좋음

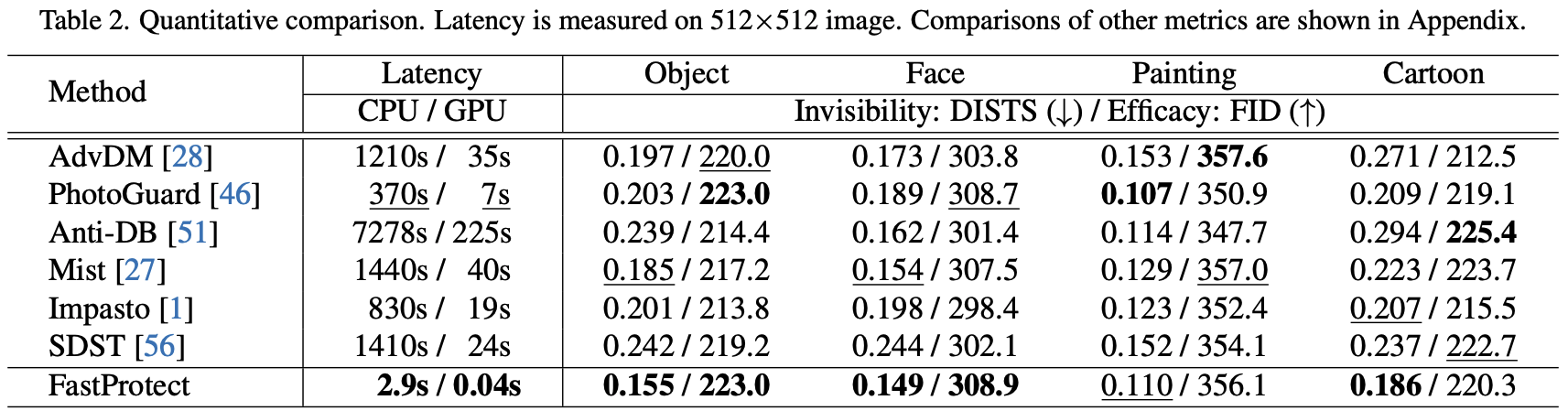

- Table 2에서 “Invisibility: DISTS (↓)”로 표기해 놓고, 각 방법별 DISTS를 비교함

- 보호 성능(FID↑) vs invisibility(DISTS↓) 사이가 완전한 trade-off라서,

- 이 논문은 *같은 보호 수준(FID 비슷)*일 때 누가 DISTS를 더 낮게 만들 수 있는지로 비교하고,

- FastProtect가 대부분 도메인에서 가장 낮은 DISTS → 즉 같이 잘 막는데 덜 티난다를 보여줌.

3. Latency?

Latency는 말 그대로:

“한 장의 이미지를 보호된 이미지로 바꾸는 데 걸리는 시간” (보호 연산의 inference time)

- 기존 방법들(Glaze, PhotoGuard, Mist, Impasto, DiffProtect 등)은

- PGD 기반 iterative optimization이어서

- 512×512 이미지 하나 보호하려고

- CPU: 5–120분,

- A100 GPU: 7–200초 걸린다고 직접 숫자까지 씀.

- Table 2에서 latency는 이렇게 측정:

- M1 Max CPU 시간 / A100 GPU 시간

- 예:

- PhotoGuard: 370s / 7s

- Impasto: 830s / 19s

- FastProtect: 2.9s / 0.04s (512×512 기준)

그래서 여기서 latency 의미는:

- 유저 입장에서 그림을 “업로드 → 보호 → 다운로드” 할 때

- 얼마나 기다려야 하냐를 직접적으로 나타내는 지표,

- 이 논문의 목표는 이 latency를 거의 0에 가깝게(실시간 수준) 만드는 것.

FastProtect는:

- perturbation을 **미리 학습(pre-training)**해 놓고

- inference 때는 거의 한 번 forward + lookup 수준으로 적용해서

- 기존 방법보다 200–3500배 빠르다고 주장함

2. Background

1. perturbation?

수학/공학에서 perturbation은 그냥:

원래 값 (x)에 아주 작게 더해지는 변화량 (\delta)

- 원래 이미지: (x)

- 살짝 바꾼 이미지: (x' = x + \delta)

여기서 (\delta) 자체가 perturbation(교란, 미세 변화).

이미지 기준으로 보면:

- 각 픽셀 값에 조금씩(예: -5, +3 같은) 더하거나 빼는 것

- 사람이 봤을 땐 거의 티가 안 나야 “작은 perturbation”이라고 부름

2. adversarial perturbation

모델을 일부러 헷갈리게 / 망하게 만들려고

아주 작게 설계된 perturbation (\delta)

고전적인 예시 (classifier):

- 모델: (f(x)) (이미지를 보고 class를 맞추는 모델)

- 원래는: (f(x) = \text{"고양이"})

- 아주 작은 (\delta)를 잘 설계해서

- (x' = x + \delta)는 사람 눈에는 여전히 고양이처럼 보이지만

- 모델은 (f(x') = \text{"개"}) 같이 틀리게 만들면,

- 이 (\delta)를 adversarial perturbation이라고 부름.

수식으로 자주 보는 형태는:

[

\begin{aligned}

\text{find } \delta \text{ s.t. } &\quad |\delta|_\infty \le \epsilon \quad (\text{픽셀당 변화는 작게}) \

& f(x + \delta) \neq f(x) \quad (\text{모델 예측은 바뀌게})

\end{aligned}

]

여기서 (\epsilon)은 “얼마나 작은 교란만 허용할지”를 제한하는 값.

3. 이 논문에서의 adversarial perturbation은 조금 다름

일반 adversarial attack은 **“한 번의 inference 결과를 틀리게 하는 것”**이 목표인데,

이 논문/이미지 protection 맥락에서의 adversarial perturbation은 조금 다른 타겟을 가짐:

- 원본 이미지: (x)

- 보호된 이미지: (x' = x + \delta)

- 이 (x')들을 가지고 LoRA, DreamBooth 같은 personalization 학습을 하면,

- 새로 학습된 diffusion 모델이

원래 사람/스타일을 제대로 mimic 못 하게 만드는 게 목표

즉 여기서의 adversarial perturbation은:

- “personalization training 과정 전체”에 대한 adversarial attack

- 목표는:

- 사람 눈에는 거의 그대로인데

- 나중에 이 이미지들을 데이터로 쓴 사람이 나를 똑같이 재현 못 하게 만드는 것

그래서:

- perturbation (\delta):

- 픽셀 스케일로 아주 작음 (invisibility)

- adversarial:

- target은 classifier output이 아니라,

- fine-tuned diffusion 모델이 생성하는 샘플 분포

- → 그 분포가 원래 내 스타일/얼굴 분포에서 많이 벗어나게 만들면 “보호 잘 됐다”고 보는 것.

4. 한 줄로 정리하면

- perturbation:

→ “원래 데이터에 더해지는 작은 변화량 (\delta)” - adversarial perturbation:

→ “모델이 잘못된 동작을 하도록,

→ 목적을 갖고 계산된 작은 변화 (\delta)” - 이 논문에서는:

→ “LoRA/DreamBooth 같은 personalization이

→ 내 이미지를 제대로 따라 하지 못하게 만드는 방향으로 최적화된

→ 작은 이미지 교란” = adversarial perturbation.

Diffusion Models.

Diffusion model은 고품질 이미지를 생성하는 능력으로 주목받아 왔음. Latent Diffusion Model (LDM) [43]은 특히 뛰어난 품질과 효율성으로 주목받음. LDM 내에서 VAE encoder E는 입력 이미지 $x$를 latent code $z = E(x)$로 변환함. 이 코드는 decoder $D$에 의해 다시 이미지 도메인으로 재구성됨; $x' = D(z')$. Diffusion process는 텍스트 프롬프트와 같은 외부 요인 $y$를 통합하여 latent code $z'$를 만듦. LDM의 학습은 각 timestep $t$에서 다음과 같은 denoising loss function에 의해 이루어짐:

$$

L_{SD} = E_{z \sim E(x), y, \epsilon \sim N(0,1), t} [||\epsilon - \epsilon_\theta(z_t, t, c(y))||_2^2]

$$

여기서 denoising network $\epsilon_\theta$는 timestep $t$와 conditioning vector $c(y)$를 기반으로 노이즈가 낀 latent code $z_t$를 복원함.

최근의 발전은 두 가지 주요 접근 방식을 통해 몇 개의 참조 이미지로 LDM의 personalization (또는 few-shot fine-tuning)을 탐구함:

- denoising network는 고정한 채 CLIP [42]의 embedding space를 활용하는 textual inversion [11]과,

- denoising network를 직접 업데이트하는 model optimization [44]이 있음.

Protection Against Diffusion-based Mimicry.

현재의 protection framework는 adversarial perturbations $\delta$를 이미지 $x$에 적용하여, projected gradient descent (PGD) [33]를 사용해 protected image $\hat{x} = x + \delta$를 생성함. protection loss $L_P$를 사용하여, 현재 방법들은 i번째 최적화 단계의 protected image를 signed gradient ascent와 step function sgn 및 step length $\alpha$를 통해 다음과 같이 얻음:

$$

x^{(i)} = \Pi_{N_\eta(x)} \left( x^{(i-1)} + \alpha \cdot \text{sgn}(\nabla_{x^{(i)}} L_P(x^{(i-1)})) \right)

$$

여기서 $\Pi_{N_\eta(x)}$는 반지름이 $\eta$인 $x$의 $L_\infty$ neighborhood에 투영함. 이 반복 과정은 $\hat{x} = x^{(N)}$이 될 때까지 $N$ 단계 동안 반복됨 (그림 2a).

목적 함수로는 주로 semantic 또는 texture loss가 사용됨 [27]. Semantic loss, $L_S(x) = L_{SD}(x)$는 LDM의 denoising process를 방해하여 원본 이미지에서 벗어난 샘플을 생성하도록 오도하는 데 사용됨. AdvDM [28]은 이 loss를 채택했고, Anti-DB [51]는 최적화 과정에 DreamBooth [44]의 업데이트 과정을 통합하여 DreamBooth에 대해 더 강건하게 개선되었음. Texture loss, $L_T(x) = -||E(x) - E(y)||_2^2$는 $x$의 latent code를 target image의 latent code 쪽으로 밀어내는 것을 목표로 함. Glaze [48]와 PhotoGuard [46]가 이 범주에 속함.

이러한 목적 함수들을 바탕으로, 우리는 universal loss를 $L_P = \lambda_S L_S + \lambda_T L_T$로 정의할 수 있으며, 여기서 $\{\lambda_S, \lambda_T\} \ge 0$는 균형을 맞추는 요소임. Mist [27]는 이 universal loss function을 활용하여 두 목적 함수의 특성을 효과적으로 포착함. Mist를 기반으로 한 Diff-Protect [56]는 더 효율적인 protection을 위해 score distillation trick을 도입함. Impasto [1]는 감지할 수 없는 protection을 위해 설계된 perceptual-oriented component를 통합함.

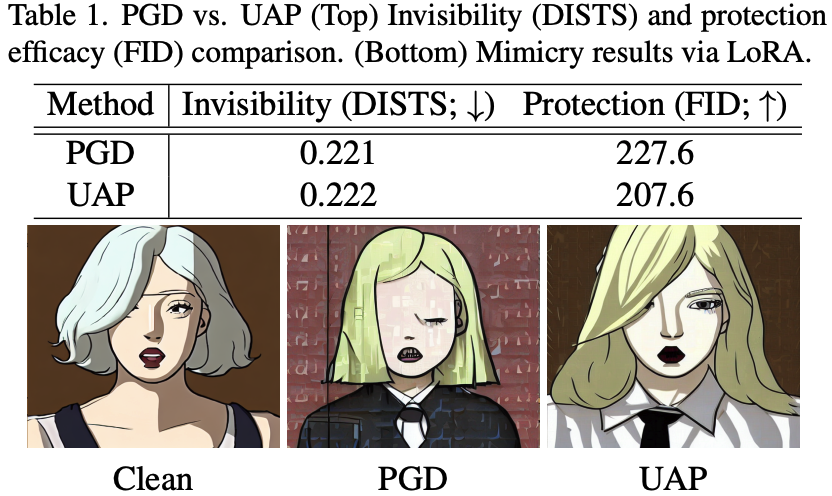

모든 현재의 protection framework는 inference 중에 iterative optimization을 활용하기 때문에, 이미지별로 고성능의 perturbation을 생성할 수 있음 [1, 27, 28, 30, 46, 48, 51, 52, 55, 56, 61]. 이러한 장점에도 불구하고, 상당한 단점은 protection을 작동시키는 데 필요한 시간이 매우 길다는 것임. 예를 들어, 512x512 픽셀 이미지를 보호하기 위해 가장 빠른 모델(예: PhotoGuard [46])조차도 A100 GPU에서 약 7초, CPU에서는 350초가 필요함. 결과적으로, 우리는 protection을 손상시키지 않으면서 효율성을 높이기 위해 이 iterative process의 대안을 탐구함.

Universal Adversarial Perturbation (UAP).

이 개념은 adversarial attack에서 도입되었으며, training dataset에서 image-agnostic perturbation을 찾기 위한 data-driven 접근 방식임 [36]. 우리 task에서는 그림 2b와 같이 UAP를 적용할 수 있음. training dataset $X_D$가 주어지면, 우리는 protection loss $L_P$를 사용하여 perceptual invisibility를 유지하기 위해 $\eta$-ball 내에서 제약된 universal perturbation $\delta$를 도출함.

$$

\delta = \arg \max_{||\delta||_\infty \le \eta} E_{x \sim X_D} [L_P(x + \delta)]

$$

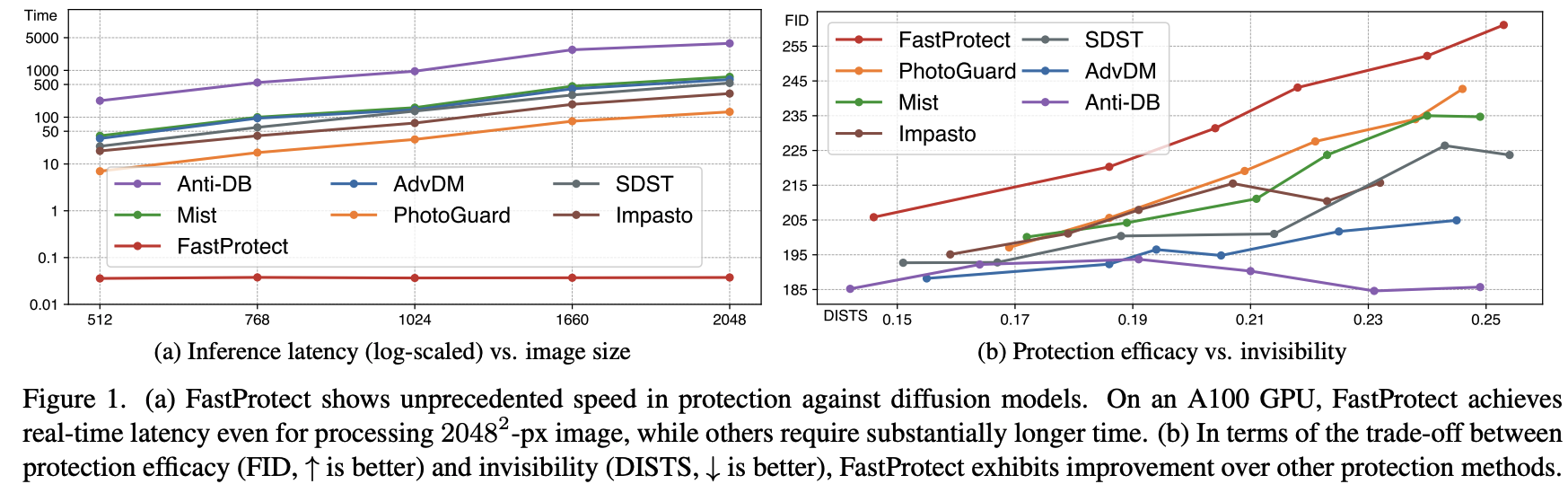

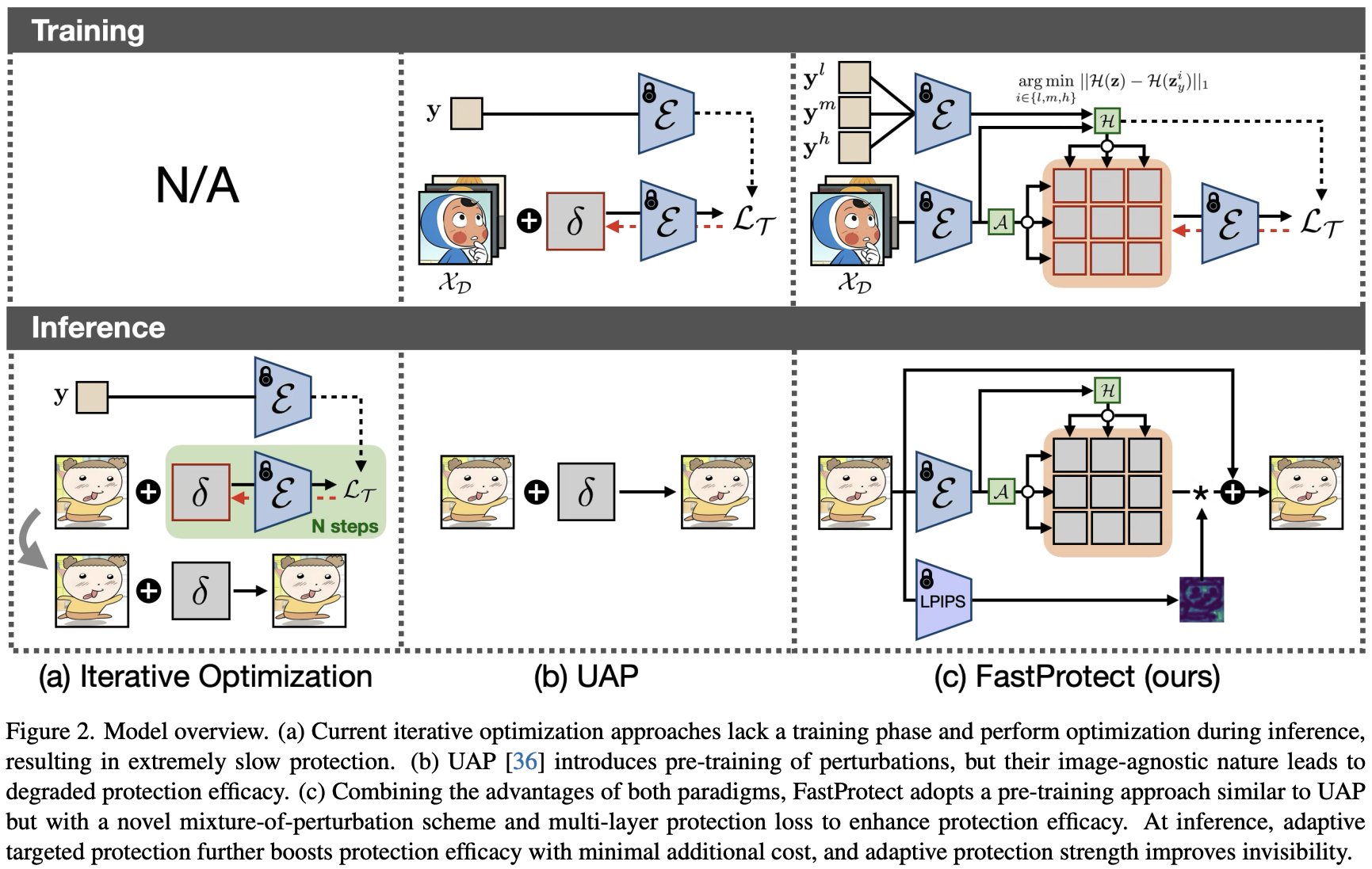

training을 통해 universal perturbation $\delta$가 확정되면, 이를 이미지 $x$에 적용하여 protected image $\hat{x} = x + \delta$를 생성할 수 있음. 이는 inference 시 계산이 필요 없기 때문에 매우 실용적임. 그럼에도 불구하고, 우리는 UAP를 우리 task에 직접 적용하면 protection performance가 크게 저하된다는 것을 발견했음. 표 1에서는 iterative optimization (PGD를 통해)과 UAP의 protection efficacy를 비교함. 우리는 protected image의 품질을 평가하기 위해 DISTS [10]를 사용하고, LoRA [17]에 의한 mimicry를 통해 생성된 이미지의 품질을 평가하기 위해 FID [15]를 사용함 (FID가 높을수록 protection이 더 좋음). LoRA에 의한 정성적인 mimicry 결과에서도 볼 수 있듯이, UAP는 protection efficacy의 현저한 저하를 초래함. 따라서 UAP와 유사한 방식으로 최소한의 inference cost로 이 pre-training 접근법을 개선하는 것이 중요함.

3. Method

3.1. Perturbation Pre-Training

Mixture-of-Perturbation (MoP).

우리는 UAP의 성능 저하가 주로 두 가지 이유 때문이라고 가정함: 1) 단일 perturbation은 diffusion models를 속이는 데 한정된 capacity를 가짐, 그리고 2) UAP의 image-agnostic 특성은 이미지의 다양한 features (e.g. texture or structure)를 포괄하지 못함. 이를 극복하기 위해, 우리는 multiple perturbations로 구성된 mixture-of-perturbations (MoP)를 도입함, $\Delta = \{\delta_1, . . . , \delta_K\}$, 여기서 K는 perturbations의 수를 나타냄. 주어진 input image에 대해, MoP는 동적으로 적절한 perturbation을 할당하고 적용하여 protected image를 생성함 (Figure 2c). 구체적으로, 이미지 x가 주어지면, MoP는 먼저 VAE encoder E를 사용하여 이를 encode하여 latent code z를 얻음. 이 code는 assignment function A에 의해 지정된 대로 적용할 특정 perturbation을 선택하는 데 사용됨. 공식적으로, protected image $\hat{x}$는 다음과 같이 생성됨:

$$

\hat{x} = x + \delta_g + \Delta_k, \text{where } k = A(E(x)), \quad (4)

$$

여기서 $\delta_g$는 global perturbation임. 우리는 $\delta_g$를 추가하면 performance가 약간 향상되는 것을 관찰했음. MoP에서, assignment function A는 input image에 기반하여 perturbations의 선택을 안내하는 중요한 역할을 하며, 유사한 이미지들이 동일한 perturbation으로 보호되도록 보장함. 이 능력은 MoP가 UAP의 capacity를 증가시킬 뿐만 아니라, UAP에는 현저히 부족한 image-specific protection의 정도를 제공할 수 있게 함. Assignment function이 없다면, naive perturbation averaging, 즉 $\hat{x} = x + \delta_g + 1/K * \Sigma_{k=1}^K \Delta_k$는 capacity를 증가시키지만 image-agnostic의 본질적인 한계를 극복하지 못해 performance benefits를 제한함. 대조적으로, 우리의 MoP는 semi-image-specific protection을 구현하여, image-agnostic 방식과 iterative approach의 image-specific 정밀도 사이에 위치하면서 비싼 inference cost를 제거함, 이는 ablation study에서 입증됨.

우리는 VAE encoder의 매우 대표적인 latent codes를 활용할 수 있는 간단한 assignment function A를 채택함.

우리의 training dataset $X_D$에 대해, VAE encoder E를 사용하여 latent codes $Z = \{z_1, . . . , z_D \}$를 추출함. 이 code들은 K-means++ [3]를 사용하여 K개의 미리 정의된 group으로 clustering됨. 단순함에도 불구하고, 이 process는 경험적으로 robustness를 보여주므로 우리 framework에 채택함.

Multi-Layer Protection Loss.

FastProtect는 texture loss에 기반한 targeted protection approach를 사용함. 전통적으로, texture loss는 VAE latent code z에 대해 계산됨, 즉 $L_T(x) = -||z - z_y||_2^2$이며, 여기서 $z_y$는 target image의 latent code임. 그러나, 우리는 종종 z-space loss가 z를 $z_y$ 쪽으로 충분히 밀어내지 못하여 suboptimal protection performance를 초래하는 것을 관찰했음. 이를 해결하기 위해, 우리는 VAE encoder에 의해 추출된 multilayer features를 사용하는 auxiliary loss를 통합함. 구체적으로, input image가 주어지면, 우리는 intermediate features $F = \{f^1, . . . , f^L\}$를 추출하며, 여기서 L은 추출된 feature layers의 수임. 유사하게, target image에 대해 $F_y$를 얻음. 그러면, balanced factor $\lambda$를 가진 우리의 제안된 multi-layer protection loss function은 다음과 같이 계산됨:

$$

L_T(x) = -||z - z_y||_2^2 - \frac{\lambda}{L} \sum_{l=1}^{L} ||F_l - F_{l_y}||_2^2. \quad (5)

$$

Auxiliary MLP loss는 z를 $z_y$ 쪽으로 밀 때 z-space를 넘어 intermediate feature spaces를 활용하므로 전반적인 protection efficacy를 향상시킴. 또한, 이러한 수정 사항들은 pre-training stage에서 구현되므로, inference 시 추가적인 computational expense 없이 protection efficacy를 향상시킴.

Training.

Assignment function A는 먼저 $X_D$에 대해 train되고, 그 다음 MoP는 Adam optimizer [22]를 사용하여 Eq. 5에 따라 $X_D$에 대해 update됨. 모든 perturbations ($\delta_g$, $\Delta$)는 512 × 512 resolution에서 initialize됨. 다른 resolution의 input images에 적용될 때, 우리는 bilinear interpolation을 통해 perturbation을 resize함. MoP에서는 두 개의 perturbations가 사용되므로, $\delta_g$, $\Delta$는 $(\eta/2)$-ball 내로 제한됨.

3.2. Adaptive Inference

Adaptive Targeted Protection.

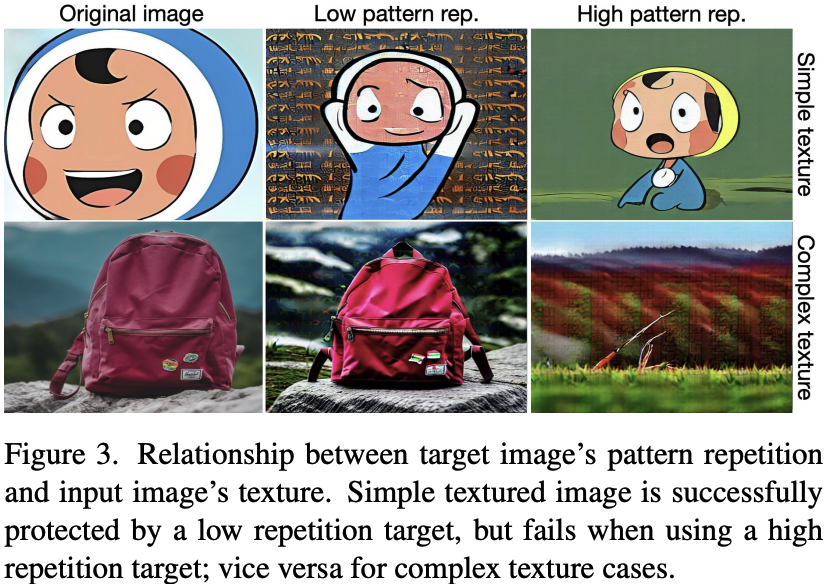

Targeted protection에서, target image는 protection performance에 영향을 미침. Liang and Wu [27]는 patterned image가 효과적이라고 언급했고, Zheng et al. [61]은 protection efficacy가 pattern repetitions에 따라 달라진다고 보고했음. 그들이 귀중한 insights를 제공하지만, target과 input images 사이의 관계는 고려하지 않음. 대신, 우리는 그러한 관계를 조사하고 adaptive targeted protection approach를 제안함.

우리의 analysis에서, 우리는 낮거나 높은 pattern repetition을 특징으로 하는 두 개의 target images를 사용하고(Appendix에 표시됨), 단순하거나 복잡한 textures를 가진 input images에 protection을 적용함. Figure 3은 이 네 가지 protection scenarios의 LoRA에 의한 mimicry outputs를 보여줌.

흥미롭게도, 우리의 관찰은 target image의 pattern repetition과 input image의 texture complexity 사이의 관계를 시사함. Zheng et al. [61]은 pattern repetition이 증가할수록 protection efficacy가 향상되지만 너무 높아지면 감소한다고 언급했음. 우리는 그들의 결과가 input image를 고정하여 texture factor를 일정하게 유지함으로써 편향되었을 수 있다고 의심함. 대조적으로, 우리의 발견은 input image의 texture complexity에 맞게 pattern image를 조정하는 것이 protection efficacy를 향상시킬 수 있음을 나타냄.

따라서, 우리는 input image에 기반하여 target image를 adaptively 선택하도록 FastProtect를 설계함. 이를 위해, 우리는 다양한 pattern repetitions를 가진 target images를 준비하고 각각에 대해 MoPs를 train함. 우리는 low, mid, high 세 가지 pattern images를 활용하여 세 개의 MoPs를 만듦: $\{\delta^l_g, \Delta^l\}$, $\{\delta^m_g, \Delta^m\}$, 그리고 $\{\delta^h_g, \Delta^h\}$. 그런 다음 각 target image에 대한 latent codes를 추출함: $z^l_y = E(y^l)$, $z^m_y = E(y^m)$, $z^h_y = E(y^h)$, 여기서 $y^l, y^m, y^h$는 각각 low, mid, high pattern repetitions를 가진 target images임. Inference 시, input image의 latent code z는 $\{z^l_y, z^m_y, z^h_y\}$와 비교되고 z에 가장 가까운 latent code를 가진 target image가 선택됨. Target images의 pattern repetition과 input image 사이의 similarity를 측정하기 위해, entropy의 L1 norm이 distance로 사용됨. 전반적으로, MoP (Eq. 4)와 adaptive targeted protection의 통합은 다음과 같음:

$$

\hat{x} = x + \delta^t_g + \Delta^t_k, \quad t = \arg\min_{i \in \{l,m,h\}} ||H(z) - H(z^i_y)||_1, \quad (6)

$$

여기서 $H(z) = - \sum_{z \in \mathbf{z}} p(z) \log p(z)$ 임. 우리의 adaptive targeted protection의 주요 장점은 다양한 domains에 걸친 robust performance이며, 이는 들어오는 이미지의 특정 domain (또는 texture)을 알 수 없는 practical use cases에서 매우 중요함. 만약 potential domains의 범위가 미리 알려져 있다면, performance difference는 크지 않을 수 있음. 그러나, 사전 domain knowledge 없이 다른 input characteristics에 적응하는 유연성은 실제 applications의 다양하고 예측 불가능한 환경에서 FastProtect의 유용성을 향상시킴.

Adaptive Protection Strength.

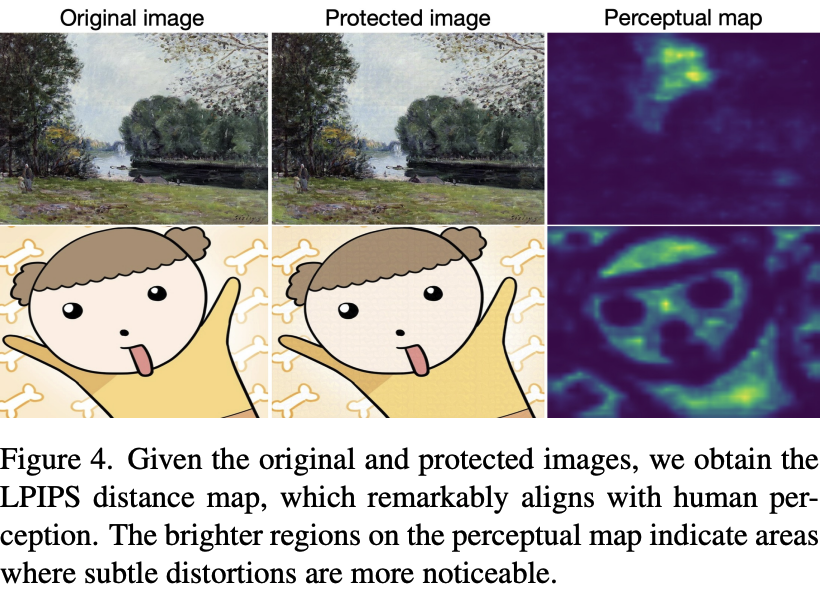

Weber–Fechner law에 따르면, 인간은 복잡한 질감의 영역보다 단순한 질감의 영역에서 미세한 변화를 더 잘 감지함. Figure 4. 원본 이미지와 보호된 이미지가 주어졌을 때, 우리는 인간의 인식과 현저하게 일치하는 LPIPS distance map을 얻음. Perceptual map의 더 밝은 영역은 미묘한 왜곡이 더 눈에 띄는 영역을 나타냄.

이를 바탕으로, Ahn et al. [1]은 human visual system을 image protection task에 적용했음. 그들은 multiple perception maps를 활용하고 optimization 중에 perturbation strength를 조정하여 invisibility를 효과적으로 향상시켰음. 그러나, Ahn et al. [1]이 사용한 perception maps는 perturbations 주입 전에 계산되므로, 이것이 보호를 위해 의도된 실제 인지된 perturbations와 완벽하게 일치하지 않을 수 있다는 가설을 세우게 됨. 더욱이, 그들이 전통적인 perceptual map algorithms의 조합에 의존한 것은 느린 processing과 performance limitations를 초래했음. 이러한 문제들을 해결하기 위해, 우리는 먼저 MoP를 적용하여 surrogate protection image를 만든 다음, perceptual map을 생성하여 확인된 문제들을 해결하는 데 도움을 줌.

구체적으로, 우리는 Eq. 6을 통해 surrogate protection image $\hat{x}$를 생성함. 그 후, LPIPS [58]를 사용하여 spatial perceptual map을 만듦, 즉 $M = \text{LPIPS}(x, \hat{x})$. Figure 4에서 볼 수 있듯이, perceptual map M은 인간의 인지적 관점과 현저하게 일치함. 따라서, 우리는 이 map을 사용하여 아래와 같이 최종 protected image를 생성함:

$$

\hat{x} = x + S(1 - M) * (\delta^t_g + \Delta^t_k). \quad (7)

$$

여기서 S(·)는 scaling function (자세한 내용은 Appendix에 있음)이고 M은 distance map 역할을 하므로 inversion step이 필요함. 이 process는 LPIPS backbone의 forward pass만 필요로 하므로, inference 시 추가적인 computational cost는 미미하며, 따라서 상당한 overhead 없이 경제적으로 invisibility를 향상시킴. Appendix에서는 perturbation pre-training과 inference process를 알고리즘 형태로 요약함.

4. Experiment

Implementation Details.

우리는 MoP에서 perturbations K의 수를 4로 설정했음.

다른 hyperparameters와 training 및 inference에 대한 자세한 내용은 Appendix에 설명되어 있음.

Datasets.

우리는 training과 benchmark datasets를 구성할 때 네 가지 domains를 활용함: object, face, painting, cartoon.

이러한 multiple scenarios는 다양한 domains의 이미지를 만날 수 있으므로, real applications에 더 가깝게 모델의 protection performance를 분석할 수 있게 함.

Dataset details는 Appendix에 제공됨.

Baselines.

우리는 기존의 diffusion-based image protection frameworks와 비교함: AdvDM [28], PhotoGuard [46], Anti-DB [51], Mist [27], Impasto [1], 그리고 Diff-Protect (SDST) [56]. 우리를 제외한 모든 다른 methods는 iterative optimization에 의존하며, texture 또는 semantic losses를 사용함.

Evaluation.

Protection efficacy는 Stable Diffusion v1.5에서 LoRA [17]에 대해 평가됨.

Latency는 M1 Max CPU와 A100 GPU를 사용하여 측정됨.

우리는 invisibility를 평가하기 위해 DISTS [10]를, protection efficacy를 정량화하기 위해 FID [15]를 사용함. Appendix에서는 더 포괄적인 비교를 위해 추가적인 metrics를 제공함.

이전 연구들은 비교를 위해 모델들 간의 protection strength를 일반적으로 고정했지만, 우리는 protection efficacy와 invisibility가 사용된 protection loss에 따라 크게 달라진다는 것을 발견했음.

예를 들어, PhotoGuard [46]와 AdvDM [28]은 서로 다른 objectives를 사용하기 때문에 다른 trends를 보임.

더욱이, invisibility 없이 protection efficacy만 평가하는 것은 real-world needs를 간과할 수 있는 좁은 평가로 이어짐.

이를 해결하기 위해, 우리는 더 공정한 비교와 practical requirements의 더 나은 반영을 보장하기 위해 methods 간의 protection level을 맞추도록 protection strength를 조정함.

그러나, 모든 methods에 걸쳐 protection strength가 동일할 때 performance가 어떻게 나타날지 궁금해할 수도 있음.

따라서, Appendix에서 고정된 strength로 평가를 제공함.

4.1. Model Comparison

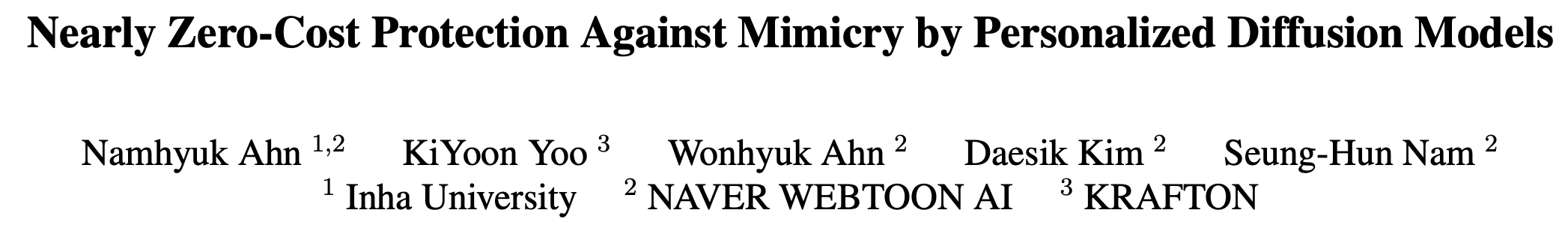

Figure 1a와 Table 2에서 볼 수 있듯이, FastProtect는 매우 빠름; CPU에서는 125배, GPU에서는 두 번째로 빠른 모델인 PhotoGuard [46]에 비해 175배 더 빠름.

놀랍게도, FastProtect는 input image size가 증가해도 일관된 latency를 유지하며, 2048px 이미지에 대해서도 거의 real-time performance를 달성함.

대조적으로, 다른 모든 frameworks는 latency에서 기하급수적인 증가를 보이며(Figure 1a), 이는 많은 최근 예술 작품들이 high-resolution인 실제 세계에서 상당한 문제를 제기함.

또한, FastProtect는 inference 중에 1.7GB의 VRAM만 차지하는 반면, 다른 methods는 8GB 이상을 필요로 함.

우리 모델의 전례 없는 속도는 매우 user-friendly하게 만듦.

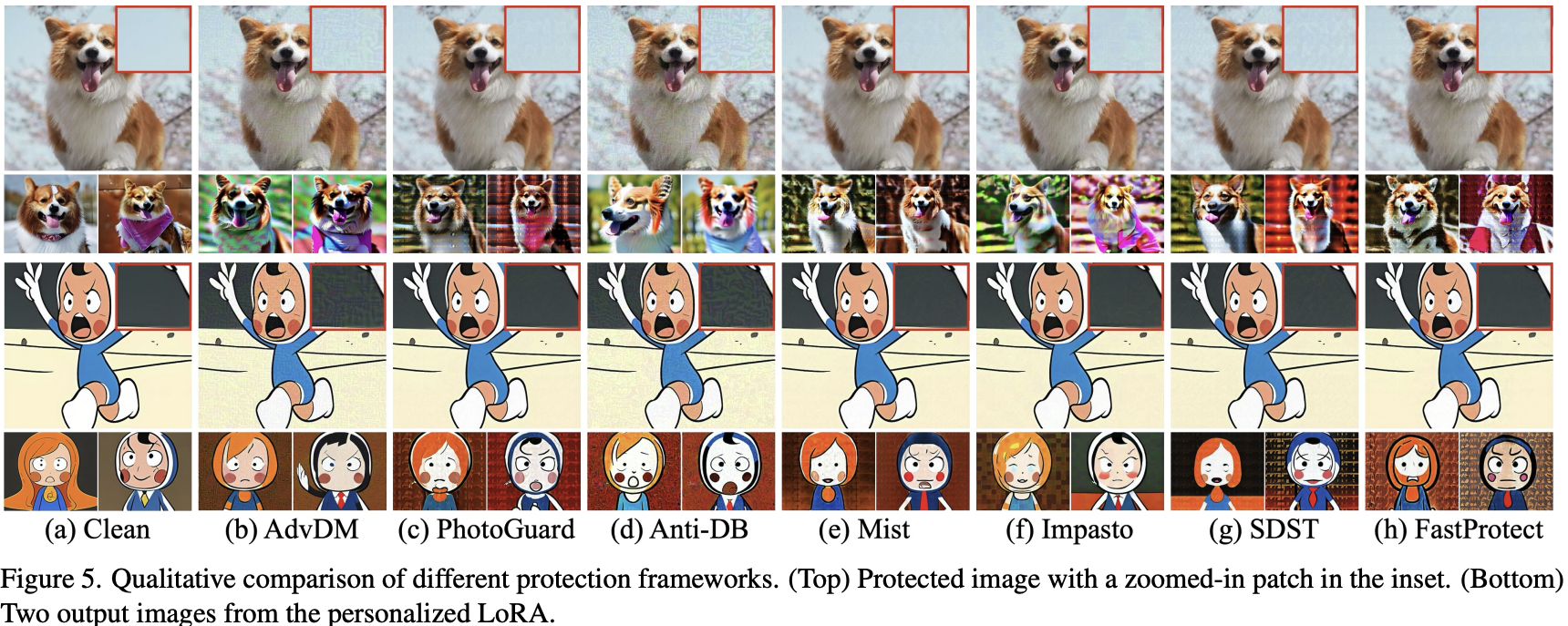

FastProtect는 또한 protection efficacy와 invisibility 사이의 우월한 trade-off를 보여줌 (Figure 1b).

비슷한 protection efficacy를 내도록 protection strength를 조정한 비교에서(Table 2), FastProtect는 대부분의 protection domains에서 일관되게 최고의 invisibility를 달성함.

painting domain에서는 두 번째로 좋은 performance를 보임. 우리의 analysis에서, FastProtect는 flat textures를 가진 영역 내에서 invisibility에 강한 이점을 보임. 이러한 features는 object와 cartoon domains에서 상당한 향상을 가져옴. 예를 들어, Figure 5는 첫 번째 행에서 하늘 영역이 FastProtect에 의해 거의 보이지 않게 렌더링되고, 두 번째 행의 cartoon에도 동일하게 적용되는 것을 보여줌. Appendix에서 입증된 바와 같이, 모든 methods의 protection strength를 동일한 값으로 고정할 때조차, 우리 method는 이 trade-off에서 유리한 균형을 달성함.

4.2. Model Analysis

Ablation Study.

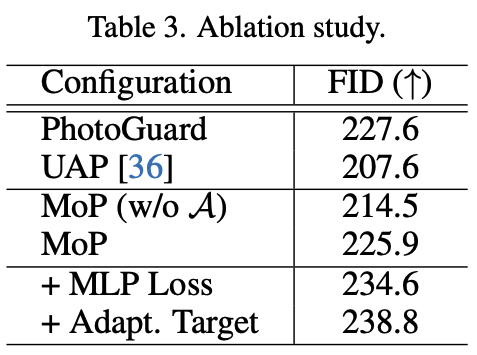

Table 3에서, 우리는 FastProtect의 component analysis를 기술함.

UAP [36]가 iterative optimization baseline인 PhotoGuard [46]에 비해 protection efficacy를 상당히 저하시킨다는 점은 주목할 만함.

반면에, 우리가 제안한 MoP를 도입하면, 잃어버린 performance를 회복함.

그러나, assignment function A를 사용하지 않으면 개선이 제한적이어서, semi-image-specific 특성을 달성하는 것의 중요성을 강조함. 논의한 바와 같이, UAP의 한계는 불충분한 capacity뿐만 아니라 image-agnostic 특성에서도 비롯됨. 단순히 perturbations의 수를 늘리는 것(즉, MoP w/o A)은 첫 번째 한계를 해결하고 UAP보다 performance를 향상시킴.

그러나, 이것은 여전히 두 번째 한계를 극복하지 못하며, 이로 인해 PhotoGuard에 비해 낮은 performance를 보임.

MoP에 assignment function을 도입하면, image features를 동적으로 고려할 수 있음. 이를 통해 MoP는 훨씬 빠른 속도를 유지하면서 iterative optimization methods의 performance와 필적할 수 있게 됨.

insun138Multi-layer protection (MLP) loss를 추가하면, protection efficacy가 크게 증가함. 유사하게, adaptive targeted protection 또한 performance를 향상시킴. 전반적으로, pre-training과 inference stages 모두에 새로운 modules를 통합함으로써, FastProtect는 훨씬 빠른 inference로 더 나은 protection efficacy를 달성할 수 있음.

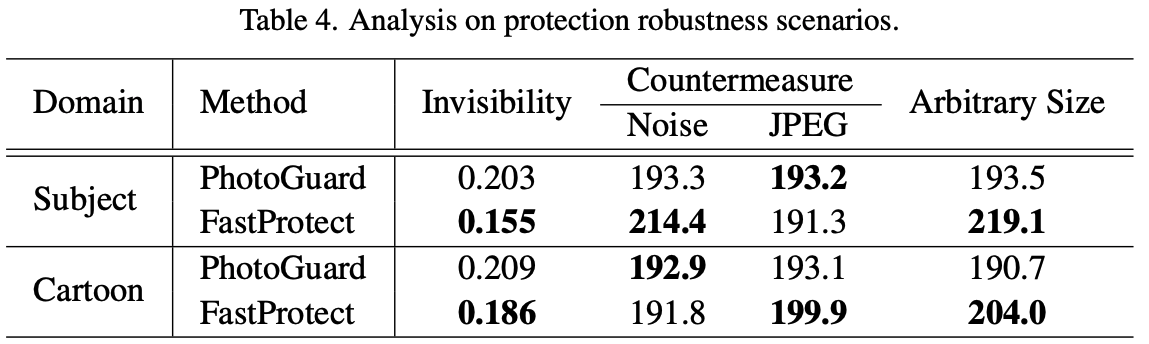

Robustness.

여기서, 우리는 protected images의 countermeasures에 대한 취약성을 분석함 (Table 4). 우리의 approach와 유사성 때문에 PhotoGuard [46]를 baseline으로 사용함. Robustness를 평가하기 위해, 우리는 Gaussian noise와 JPEG compression과 같은 countermeasures에 대해 평가함. 추가적으로, 우리는 input image가 임의의 dimensions를 가질 수 있는 더 현실적인 scenario를 고려함. Image protection tasks의 대부분 이전 평가는 일반적으로 512²의 고정된 image resolution을 가정하는데, 이는 이상적인 scenario를 나타냄. 실제로, image sizes와 aspect ratios는 다양함. 우리 모델은 이러한 countermeasures에 대해 비슷한 performance를 보이며, 특히 arbitrary size scenario에서 FastProtect는 더 나은 performance를 보임. 이는 MoP를 다른 sizes에 맞추기 위해 단순히 interpolation을 사용하는 것이 간단하고 효과적임을 시사함.

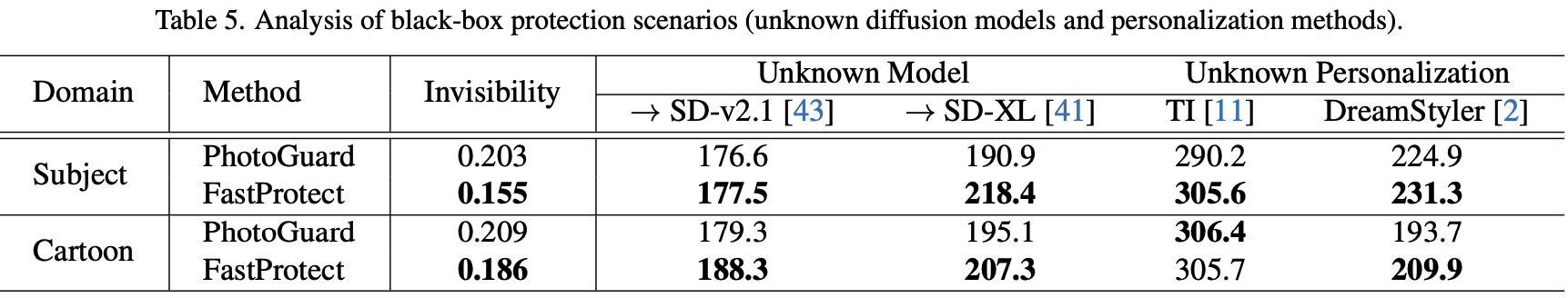

Black-Box Scenario.

Table 5는 black-box scenarios에서의 model analysis를 제시함. 우리는 두 가지 경우를 검토함: unknown model scenario, 여기서 우리는 protection methods를 다른 Stable Diffusion (SD) backbones, 구체적으로 SD v2.1 [43]과 SD-XL [41]로 transfer함. 또한 우리는 Textual Inversion (TI) [11]과 DreamStyler [2]를 적용하여 이미지를 복제함으로써 unknown personalization에 대한 image protection을 평가함. 이러한 scenarios에서, FastProtect는 baseline에 비해 우수한 invisibility를 보이면서 black-box settings에서 비슷하거나 더 나은 performance를 달성함.

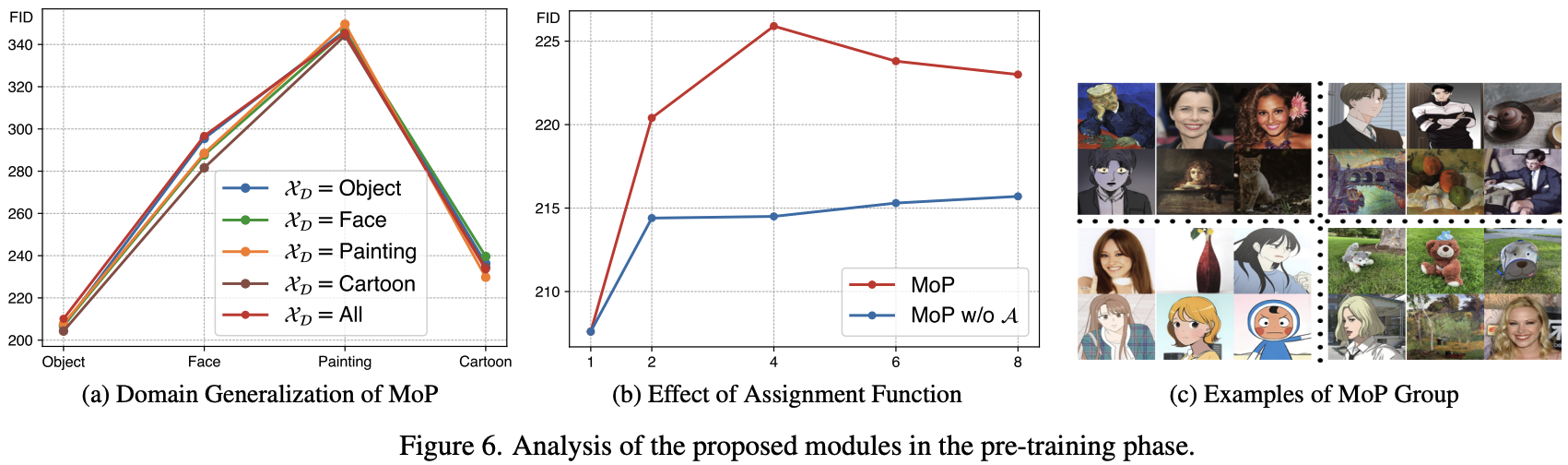

Mixture-of-Perturbation.

Figure 6a에서, 우리는 training dataset $X_D$를 변경하며 protection efficacy를 측정함. 흥미롭게도, training domain이 제한될 때조차 protection performance에 큰 차이가 없음. 우리는 MoP가 adaptive perturbation selection mechanism 덕분에 보지 못한 domains를 효과적으로 처리한다고 추측함. 그러나, 모든 domains를 사용하는 것이 약간 더 낫기 때문에, 우리는 이 strategy로 train함. 추가적으로, Figure 6b는 K를 변경하고 MoP에서 assignment function A를 제외하여 FastProtect를 비교함.

Assignment function 없이는, performance improvement가 제한적이며, full MoP의 경우, K = 4에서 수렴하며 훨씬 더 나은 efficacy를 달성함. Figure 6c에서는, K = 4일 때 각 perturbation에 할당된 대표적인 이미지들을 visualize함. 이미지들은 특정 구별되는 features(e.g., texture, scene)에 의해 그룹화됨.

Adaptive Targeted Protection.

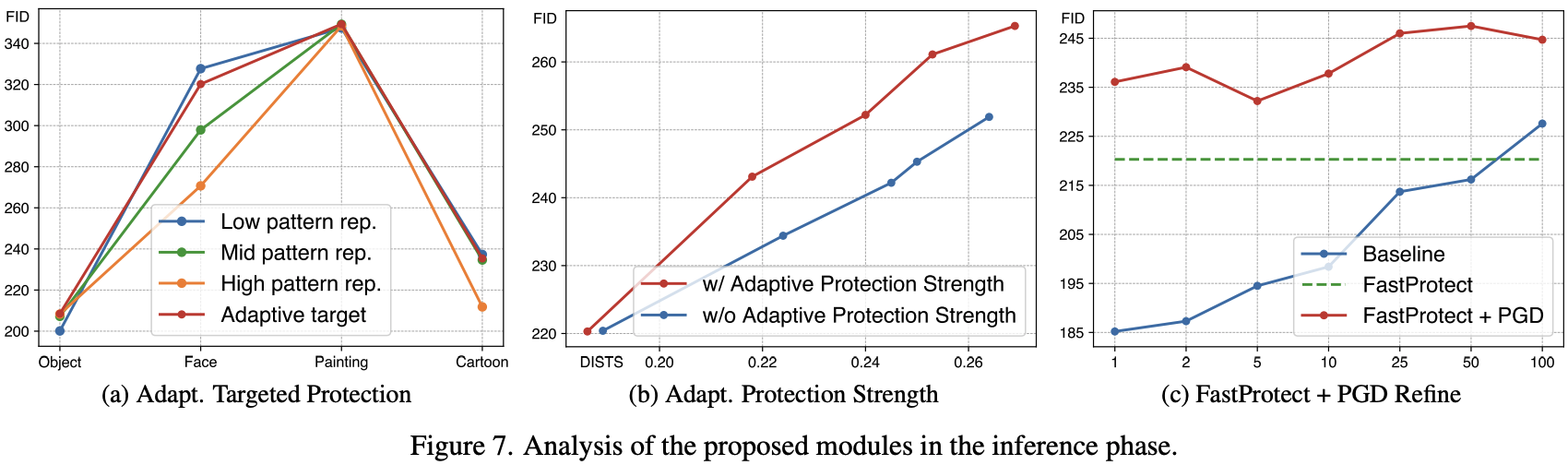

Figure 7a는 protection efficacy와 target image 간의 관계를 분석함. Low pattern repetition을 가진 target image를 사용하면, Face와 Cartoon domains에서는 protection이 효과적이지만 Objects에 대해서는 덜 효과적임. 대조적으로, high-repetition target image는 Object domain에서 강력한 performance로 이어짐. 제안된 adaptive targeted protection은 모든 scenarios에서 거의 최적의 performance를 보여줌. Real-world use cases에서 어떤 domain을 마주칠지 예측하기 어렵기 때문에, 고정된 target image로 단일 domain에 의존하는 것은 실용적이지 않음. 따라서, FastProtect에 adaptive protection을 통합하는 것은 real-world applications에서 더 robust한 protection solution을 만드는 데 필수적임.

Adaptive Protection Strength.

우리는 Figure 7b에서 perturbation budget을 조정하여 제안된 adaptive protection strength를 사용하는 것의 영향을 분석함. 이 module이 없으면, protection efficacy와 invisibility 간의 trade-off는 full model보다 나쁨. Budget이 작을 때는 perturbation이 본질적으로 미미하므로 그 차이는 미미할 수 있음. 그러나, 더 강한 protection에서는 그 차이가 중요해짐.

FastProtect + Iterative Optimization.

FastProtect는 매우 빠르므로, 충분한 computing resources를 가진 사용자는 훨씬 더 효과적인 protection을 달성하기 위해 추가적인 computation을 투자하고 싶을 수 있음. 이 scenario를 고려하여, Figure 7c에서는 FastProtect의 결과를 initial perturbation으로 사용하고 PGD(e.g. PhotoGuard [46])를 사용하여 추가로 refine함. FastProtect에 PGD를 적용하면 invisibility가 감소하는 경향이 있으므로 baseline인 PhotoGuard는 약간 더 큰 budget으로 표시함에 유의해야 함. 따라서, baseline budget은 FastProtect + PGD의 invisibility level에 맞추도록 조정됨. 놀랍게도, 우리 method는 iterative optimization techniques에 대한 우수한 initial checkpoint 역할을 함. 예를 들어, baseline은 우리의 initial results와 일치시키기 위해 100 steps가 필요한 반면, FastProtect + PGD는 훨씬 더 높은 protection efficacy로 단 25 steps 만에 converge함.

5. Conclusion

본 연구에서는 pretrained mixture-of-perturbations를 활용하여 low latency를 달성하는 FastProtect를 제안함.

또한 protection efficacy 감소를 보완하고 perturbation의 invisibility를 향상시키기 위한 adaptive inference를 제안함.

실험 결과, FastProtect가 기존 방법들과 동등한 수준의 protection 성능을 유지하면서도 invisibility를 향상시키고 inference time을 크게 단축한, 보다 practical한 솔루션을 제공함을 보임.

Limitations.

FastProtect는 여전히 일부 visible distortion을 발생시키며, 이는 adversarial perturbations를 사용할 때 피하기 어려운 한계점으로 남아 있음.

향후 연구는 이러한 한계를 넘어서 image quality를 최대화할 수 있는 새로운 paradigm을 찾는 데 초점을 맞출 필요가 있음.

In this work, we propose FastProtect, which leverages pretrained mixture-of-perturbations for low latency. We also propose adaptive inference to compensate the loss of the protection efficacy and to improve the invisibility of the perturbation. Our experiments demonstrate that FastProtect offers a more practical solution with comparable protection performance to existing methods, with improved invisibility and substantially reduced inference time. Limitations. FastProtect still produces some visible distortion and this is an unavoidable drawback when using adversarial perturbations. Future research should focus on finding new paradigms that can maximize the quality