ECCV 2024

Keywords: Representation learning · Foundation models · Gaussian splatting · Scene understanding

https://arxiv.org/abs/2407.20229

Improving 2D Feature Representations by 3D-Aware Fine-Tuning

Current visual foundation models are trained purely on unstructured 2D data, limiting their understanding of 3D structure of objects and scenes. In this work, we show that fine-tuning on 3D-aware data improves the quality of emerging semantic features. We

arxiv.org

Improving 2D Feature Representations by 3D-Aware Fine-Tuning

Current visual foundation models are trained purely on unstructured 2D data, limiting their understanding of 3D structure of objects and scenes. In this work, we show that fine-tuning on 3D-aware data improves the quality of emerging semantic features. We

ywyue.github.io

0. Abstract

현재의 visual foundation model들은 순전히 비정형(unstructured) 2D 데이터로만 학습되어, 객체와 장면의 3D 구조에 대한 이해가 제한됨.

본 연구에서는 3D-aware 데이터에 대한 fine-tuning이 생성되는 semantic feature의 품질을 향상시킨다는 것을 보여줌.

우리는 semantic 2D feature들을 효율적인 3D Gaussian representation으로 lift하는 방법을 설계하며, 이는 임의의 시점에서 해당 feature들을 다시 렌더링할 수 있게 함. 렌더링된 3D-aware feature들을 사용하여, 우리는 이러한 3D 인식 능력을 2D foundation model로 전달하는 fine-tuning 전략을 설계함.

우리는 이러한 방식으로 fine-tuning된 모델이 간단한 linear probing을 통해 semantic segmentation 및 depth estimation과 같은 downstream task의 성능을 쉽게 향상시키는 feature를 생성함을 입증함. 주목할 점은, 단일 실내 데이터셋에서 fine-tuning되었음에도 불구하고, 이러한 성능 향상은 다양한 실내 데이터셋과 out-of-domain 데이터셋으로 전이 가능함.

우리는 본 연구가 2D foundation model을 학습할 때 3D 인식 능력을 주입하는 것을 커뮤니티가 고려하도록 장려하기를 바람.

프로젝트 페이지: https://ywyue.github.io/FiT3D.

1. Introduction

- deep neural networks의 emergence 이후, vision systems은 대체로 2D 데이터셋으로 학습되어 왔음.

- vision transformers (ViT)와 같은 최신 아키텍처의 확장성 덕분에, 여러 대규모 비전 모델들이 supervised 또는 self-supervised learning을 통해 풍부한 2D 이미지 집합으로 학습되었음.

- Visual foundation model들은 segmentation, depth estimation, 또는 correspondence estimation과 같은 downstream task의 결과를 개선하는 데 적용될 수 있는 일반적인 feature extractor로서 인상적인 유용성을 보여주었음.

- 이 모델들은 쉽게 구할 수 있는 대량의 2D 이미지로 학습되며, 따라서 2D 픽셀 공간에서 객체와 장면 구조에 대한 통계를 학습함.

- 우리의 3D 세계를 단순하게 투영한 이미지들은 얻기 쉽고 시각 세계를 효율적으로 묘사하는 방법을 제공하지만, 동시에 명시적인 3D geometry 정보를 버림. 순전히 2D 이미지로만 학습된 vision systems은 우리 세계의 기저에 있는 3D structure를 완전히 이해할 수 없을 것으로 예상됨. 우리 3D 세계에는 multi-view consistency나 single-view의 모호성을 해결하기 위한 multi-view fusion과 같은 몇 가지 유망한 속성들이 있음.

- 이러한 모델들의 학습 설정에서 중요한 한계는, 보이는 객체seen objects의 3D 구조에 대해 완전히 추론reason하지 않는다는 점임. 학습 이미지는 여러 시점에서 동일한 객체를 관찰한 것을 매칭할 수 있게 하는 multi-view나 video correspondence 없이 비정형적인 방식으로 네트워크에 제공됨.

- 결과적으로, 이 모델들은 객체에 대한 3D 이해가 제한적이며, 예를 들어 다른 시점에서 관찰했을 때 view-consistent한 feature를 생성하지 못함.

- 대조적으로, 우리 인간이 이미지를 관찰할 때는 2D 시각 콘텐츠를 인식할 뿐만 아니라, 평생에 걸친 stereo 및 시간적 정보의 관찰을 통해 학습한 기저의 3D structure를 추론하여 활용함으로써 손쉽게 전체적인 이해를 달성함.

- 본 연구에서는 대규모 2D 비전 모델들이 적절한 종류의 데이터를 보여줌으로써 유도되는 3D-aware 이해 능력을 갖추게 되면 이점을 얻을 수 있는지 탐구함.

이를 위해, 우리는 2D foundation model의 3D-aware 이해 능력을 향상시키기 위한 새로운 2단계 접근법을 설계함.

- 첫 번째 단계에서는, 학습 데이터로서 3D-aware feature를 얻는 것을 목표로 함.

- 최근 neural scene representation의 발전에 동기를 받아, 우리는 multi-view 2D foundation feature를 효율적인 3D Gaussian representation으로 lift하는 접근법을 설계함.

- 이 lifting 과정은 multi-view consistency를 활용하여 다른 시점의 2D feature들이 서로 보완할 수 있도록 함.

- 더욱이, multi-view RGB guidance로부터 생성된 학습된 3D 구조 덕분에, 융합된 feature들(그림 1 (c))은 미세한 디테일을 가진 고해상도를 보여줌.

- 일단 학습되면, 3D Gaussian은 임의의 시점에 대한 feature를 렌더링할 수 있음. 이하에서는, 이러한 방식으로 얻어진 feature를 3D-aware라고 칭함.

- 두 번째 단계에서는, 렌더링된 3D-aware feature를 사용하여 2D foundation model을 fine-tune함(그림 2).

- 이를 위해, 이러한 3D 인식 능력을 2D foundation model로 전달하는 효율적인 fine-tuning 전략을 설계함.

- fine-tuning 후, 더 나은 3D 이해로부터 이점을 얻을 수 있는 downstream task, 즉 semantic segmentation과 depth estimation에서 feature 품질을 평가함.

광범위한 실험을 통해 3D-aware feature를 통합하는 것이 간단한 linear probing으로 downstream task를 개선하고 out-of-domain 데이터셋에 대한 일반화 능력을 보임을 입증함.

2. Related Work

2.1절에서는 최근의 self-supervised 2D representation learning 기술에 대한 개요를 제공하고,

2.2절에서는 생성된 feature들이 어떻게 3D representation으로 distill되었는지 설명함.

그 다음, 2.3절에서는 3D 정보를 활용하여 2D representation 방법을 개선한 이전 연구들을 논의함.

2.1. 2D Representation Learning

Representation learning은 이미지 domain에서 놀라운 발전을 이루었음.

이는 풍부한 데이터 집합으로부터 일반화 가능한 시각적 feature를 학습하는 것을 목표로 함.

Self-supervised representation learning은 labeled data를 필요로 하지 않기 때문에 특히 많은 관심을 받았음.

초기 연구들은 pre-training을 위해 pretext task를 사용했는데, 이는 데이터의 고유한 속성을 활용하여 surrogate label을 자동으로 생성하는 것을 목표로 함.

이후, contrastive learning이 이미지 또는 이미지 그룹 간의 discriminative signal을 활용하여 representation learning에 널리 사용되었음.

더 최근에는 BERT에 영감을 받아, masked image modeling이라는 새로운 패러다임이 확장 가능한 시각적 학습을 위해 제안되었음. 그럼에도 불구하고, 이러한 모든 방법들은 기저의 3D 구조에 접근하지 않고 2D 이미지 데이터로만 학습됨.

우리 연구는 순전히 2D 관찰로부터 학습된 feature들을 3D awareness로 보완하는 것을 목표로 함.

2.2 Distilled Feature Fusion Fields

Neural radiance fields (NeRF)는 고품질 3D 재구성 및 novel view synthesis를 위한 유망한 scene representation으로 부상했음. 최근 일부 연구들은 DINO, CLIP, LSeg, 또는 OpenSeg와 같은 사전 학습된 이미지 feature를 neural rendering을 통해 NeRF로 distill하는 것을 탐구함.

어떠한 label도 요구하지 않으면서, 이러한 distilled feature fusion fields는 segmentation, scene editing, open-vocabulary query와 같은 여러 zero-shot 3D scene understanding task를 가능하게 함.

우리는 2D feature를 3D representation으로 distill함으로써 이러한 연구들로부터 유사한 영감을 공유함.

그러나, feature field를 이용한 perception task에 초점을 맞추는 대신, 우리는 렌더링된 3D-aware feature를 활용하여 역으로 2D feature extractor를 개선하는 데 관심이 있음.

우리는 전달된 3D awareness가 semantic 및 geometric task 모두에서 2D feature를 즉시 개선할 수 있음을 보여줌.

또한, 우리는 최근의 Gaussian-based representation을 확장하여, 높은 효율성과 메모리 사용량을 유지하면서 2D feature를 3D Gaussian으로 distill하는 방법을 설계함.

semantic feature를 가진 3D Gaussian을 소개하는 여러 동시 연구들이 있음. 그러나, 이들 중 어떤 연구도 feature를 다시 2D 모델로 distill하지는 않음. 우리 연구는 3D representation으로 융합된 semantic feature가 fine-tuning을 통해 2D foundation model을 효과적으로 개선할 수 있음을 처음으로 보여줌.

2.3 Injecting 3D Priors to 2D

기존 연구들은 주로 multi-view 2D feature를 3D representation으로 융합하는 데 초점을 맞추었음.

3D awareness를 2D representation learning에 통합하는 반대 방향에 대해서는 거의 주목받지 못했음.

Pri3D는 RGB-D 재구성으로부터 얻은 geometric constraint(multi-view consistency 및 2D-3D correspondence)를 사용하여 contrastive learning으로 이미지 기반 representation을 위한 3D prior를 학습함.

최근, masked autoencoder (MAE)에 영감을 받아, 여러 연구들이 masked image modeling 전략을 채택하여 3D prior를 학습함. 그러나, 이러한 모든 방법들은 일반적으로 Vision Transformer (ViT) backbone인 2D feature extractor를 그들이 직접 만든 pretext task를 사용하여 pre-training해야 함.

이렇게 사전 학습된 모델들은 fine-tuning을 통해 downstream task에 사용됨.

대조적으로, 우리는 multi-view 융합 feature에 내장된 3D awareness를 적은 계산 자원으로 fine-tuning을 통해 2D feature extractor에 전달하는 것을 목표로 함.

우리의 3D-aware feature는 간단한 linear probing으로 downstream task 성능을 즉시 향상시킴.

또한, 우리는 우리의 3D-aware feature가 원래의 2D feature에 비해 더 깨끗하고 상세한 feature map을 보여준다는 것을 발견했으며(부록 D절 참조), 반면 여러 동시 연구들은 특히 2D feature map을 denoise하거나 sharpen하는 데 중점을 둠.

3. Method

이 섹션에서는 3D-aware feature를 사용하여 2D foundation model을 fine-tuning하는 우리 방법을 소개함.

우리는 2단계 파이프라인을 제시함 (그림 3 참조).

- 첫 번째 단계에서는, 각 view의 2D feature들을 multi-view consistent하고 3D-aware한 representation으로 lift함. 이 representation과 설정은 3.1절에 설명되어 있음.

- 두 번째 단계에서는, 얻어진 3D-aware feature representation을 학습 데이터셋으로 사용하여 2D feature extractor를 fine-tune하며, 이는 3.2절에서 자세히 설명됨. 마지막으로, 3.3절에서 feature 평가를 위한 linear probing 방법론을 설명함.

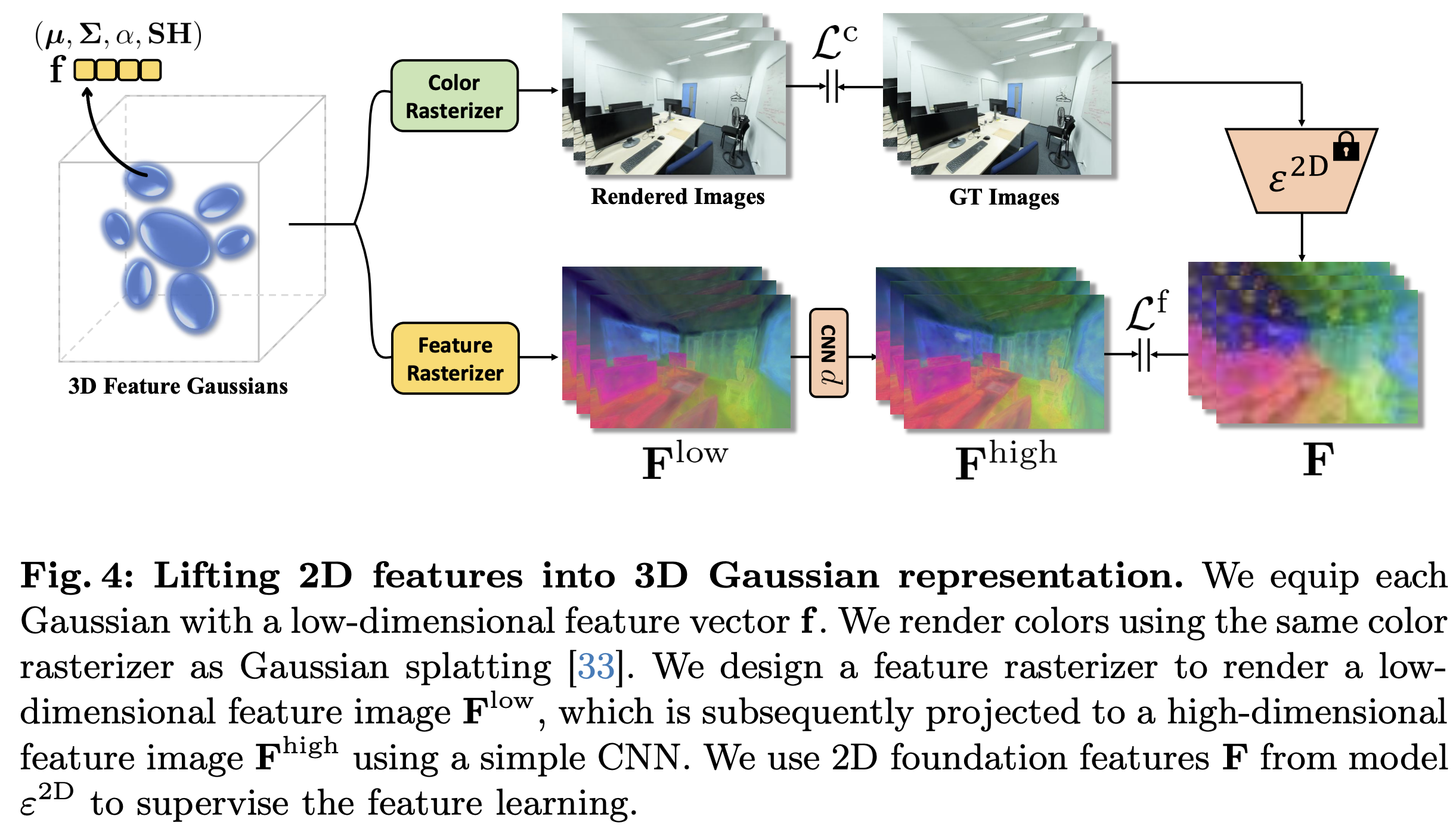

3.1. Lifting Features to 3D

semantic 2D feature를 3D로 lift하는 것은 최근의 트렌드가 되었으며, 여러 다른 옵션들이 존재함 (2절 참조).

더 많은 양의 scene을 2D 모델의 학습 데이터로 사용하는 우리의 목적을 위해서는, 가장 중요한 측면은 효율성임.

이 representation은

(1) 수많은 scene을 3D representation으로 효율적으로 맞출 수 있어야 하고,

(2) 2D foundation model의 fine-tuning 루프에 효율적으로 통합되기 위한 빠른 렌더링 메커니즘을 가져야 함.

따라서, 우리는 빠른 최적화와 실시간 렌더링을 가능하게 하는 3D Gaussian splatting의 최신 발전을 활용함.

그림 4는 우리가 2D foundation feature를 lift하기 위해 Gaussian splatting을 어떻게 확장하는지 보여주며, 그 방법은 아래에 자세히 설명함.

3D feature Gaussians

3D Gaussian splatting의 공식을 차용하여, 우리는 3D Gaussian들의 집합 G를 다음과 같이 정의함:

$$

G = \{(\mu, s, R, \alpha, SH, f)_j\}_{1 \le j \le M}

$$

여기서 μ ∈ R³은 Gaussian의 3D mean임. S = diag(s) ∈ R³×³은 Gaussian scale이며, R ∈ R³×³은 orientation임. α ∈ R은 각 Gaussian의 opacity를 의미함. SH는 시점에 따라 달라지는 color를 인코딩하는 spherical harmonic coefficient vector임.

Gaussian covariance matrix Σ는 scale과 orientation을 결합하여

[

\Sigma = R S S^\top R^\top

]

형태로 얻어짐.

기존 파라미터들에 더해, 우리는 3D 공간에서 distill된 2D feature를 저장하기 위해 per-Gaussian feature vector ( f \in R^D )를 도입함.

이 feature vector들은 우리가 설계한 feature rasterizer를 사용해 2D feature 이미지로 rasterize됨.

Gaussian splatting의 differentiable color rasterizer로부터 영감을 받아, 우리는 point-based α-blending 방식으로 feature를 다음과 같이 rasterize함.

[

F^{low} = \sum_{i \in \mathcal{N}} f_i \alpha_i \prod_{j=1}^{i-1} (1 - \alpha_j).

]

여기서 N은 해당 픽셀과 겹치는 순서 있는 Gaussian들의 집합임. fᵢ는 각 Gaussian의 feature이며, αᵢ는 covariance Σ를 갖는 2D Gaussian을 평가한 값에 학습된 per-point opacity를 곱하여 얻어짐.

Up-projecting features.

3D Gaussian을 representation으로 사용할 때의 큰 한계는 memory consumption이 매우 크다는 점임.

하나의 scene에 수백만 개의 Gaussian이 존재할 수 있으므로, 예를 들어 384차원의 DINO feature를 각 Gaussian에 직접 저장하는 것은 불가능함.

따라서 memory 효율성과 빠른 rendering 속도를 유지하기 위해, 우리는 D ≪ 384인 저차원 feature ( f \in R^D )만 저장하는 방식을 선택함.

그리고 렌더링 이후 feature 이미지를 고차원 feature space로 up-project하기 위해 scene-specific pixel-space CNN decoder

[

d: F^{low} \rightarrow F^{high}

]

를 학습함.

이 접근 방식이 도입하는 trade-off는 Sec. 4.6에서 분석함.

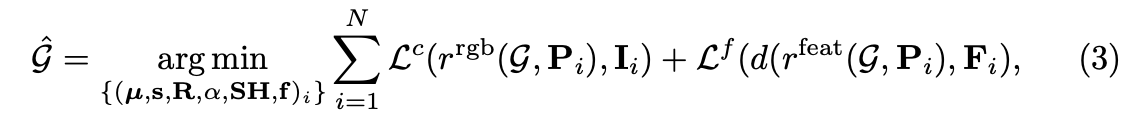

Optimization

주어진 한 scene에 대해, distill된 feature를 포함한 전체 3D Gaussian representation은 optimization을 통해 얻어짐.

어떤 scene의 multi-view 이미지들의 집합을 {Iᵢ}₁≤ᵢ≤ₙ, 이에 대응하는 카메라 파라미터,

그리고 2D feature extractor (예: DINOv2)로부터 나온 feature map들의 집합을 {Fᵢ}₁≤ᵢ≤ₙ라고 하자.

또한, 카메라 포즈 Pᵢ를 사용하여 Gaussian 집합을 RGB 이미지나 feature 이미지로 각각 렌더링하는 rasterization 함수를 r_rgb, r_feat라고 함.

그러면, 이미지 Iᵢ와 feature 이미지 Fᵢ를 최적으로 표현하기 위해 Gaussian 파라미터를 다음과 같이 optimize함:

$$

\hat{G} = \arg\min_{\{(μ,s,R,α,SH,f )i\}} \sum_{i=1}^{N} L_c(r_{rgb}(G, P_i), I_i) + L_f (d(r_{feat}(G, P_i), F_i))

$$

여기서 Lc는 RGB 이미지에 대한 pixel-wise l1 loss와 D-SSIM 항을 결합한 것이고,

Lf는 feature 이미지에 대한 pixel-wise l1 loss임.

주목할 점은, 우리는 Lf (feature 이미지)로부터 오는 gradient로는 f만 optimize하고, 나머지 파라미터들은 Lc (RGB loss)에 대해서만 optimize한다는 것임.

feature space로부터의 loss는 정확한 Gaussian mean, covariance, opacity로 이어지지 않기 때문에, 이 방법은 일관된 3D feature representation을 얻는 데 필수적임이 입증되었음.

우리는 그 이유가 2D feature extractor의 3D consistency가 부족하기 때문이라고 추측함. 오직 3D-consistent한 representation으로 강제함으로써, 우리는 결과적으로 feature들을 일관성 있게 만듦.

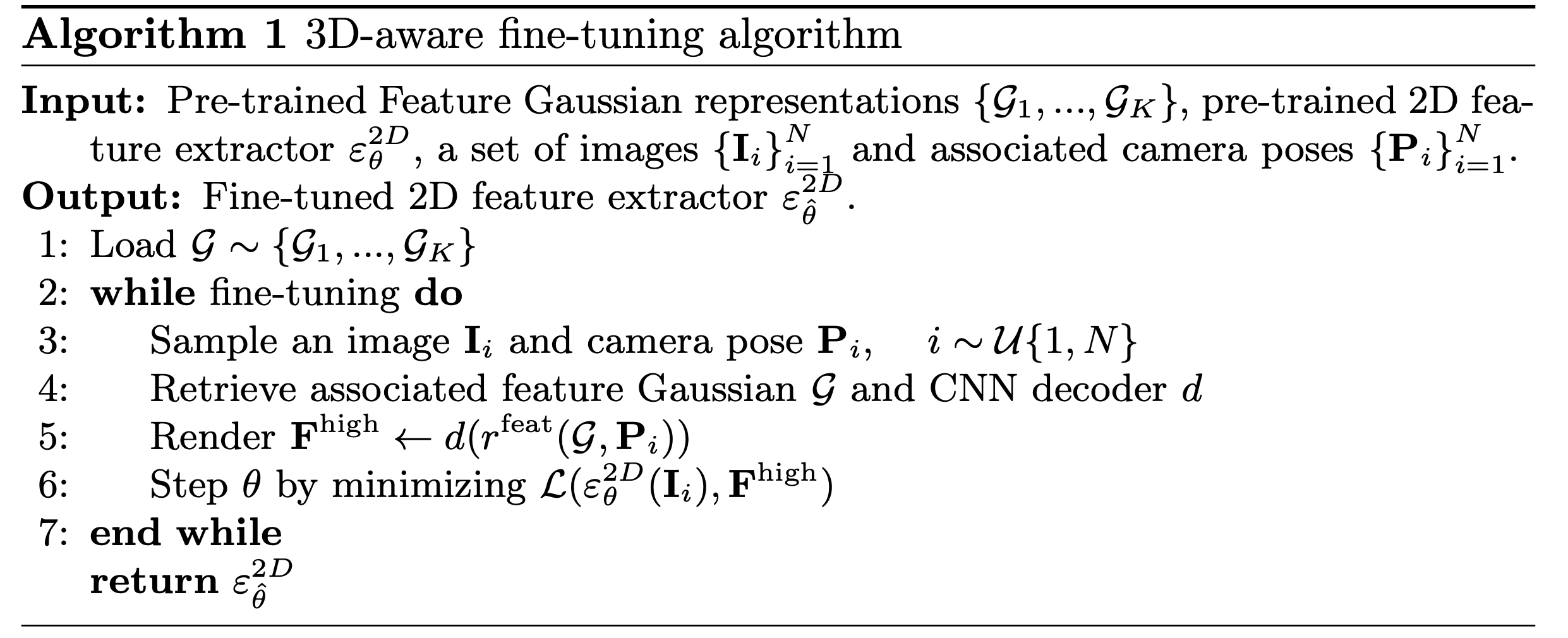

3.2. 3D-Aware Fine-Tuning

이전 섹션에서 설명된 절차는 K개 scene의 3D feature Gaussian representation을 fitting하는 데 사용됨.

3D-aware fine-tuning의 알고리즘은 Algorithm 1에 요약되어 있음.

fine-tuning 과정은 원본 2D feature map과 3D-aware feature map의 학습 쌍을 필요로 함.

feature map을 저장하는 것은 메모리를 많이 차지하므로, 우리는 학습 쌍을 on the fly로 생성함.

각 사전 학습된 Gaussian을 렌더링할 때 로드하는 것이 시간이 많이 걸리는 것을 고려하여, 우리는 모든 Gaussian을 CPU 메모리에 미리 로드함. 학습 루프의 각 단계에서, 우리는 모든 학습 이미지로부터 무작위로 view 하나를 샘플링한 다음, 연관된 feature Gaussian과 scene-specific CNN decoder를 검색하고, 마지막으로 fine-tuning을 위한 ground truth feature로서 F_high를 렌더링함. fine-tuning loss는 F_high(리사이즈된)와 fine-tuning되는 2D feature extractor의 출력 feature 간의 l1 loss임.

위의 설계는 fine-tuning 과정을 효율적으로 만들고 메모리 소비를 통제 하에 둠. 주목할 점은, 우리는 추가적인 네트워크 구성 요소를 도입하지 않고 작은 learning rate로 적은 수의 epoch(예: DINOv2의 경우 1 epoch)만으로 2D feature extractor를 fine-tuning하면 됨. fine-tuning 과정은 빠르고 계산 친화적임. fine-tuning 시간에 대한 분석은 4.6절에 있음.

3.3. Linear Probing for Downstream Tasks

3D-aware feature에 대해 fine-tuning한 후, 우리는 표준 벤치마크 downstream task 집합에서 생성된 feature들을 평가함. 이를 위해, 우리는 feature들 위에 linear head를 학습시켜 여러 데이터셋에서 semantic segmentation과 depth estimation task를 해결함.

Semantic segmentation.

patch token들로부터 class logit을 예측하도록 linear layer가 학습됨. 이 linear layer는 저해상도 logit map을 생성하고, 이는 segmentation map을 얻기 위해 전체 해상도로 upsample됨.

Depth estimation.

우리는 ViT의 [CLS] 토큰을 각 patch token에 concatenate함. 우리는 depth 예측 범위를 256개의 균일하게 분포된 bin으로 나누고 linear normalization을 사용함. 그 다음, 간단한 linear layer가 classification loss를 사용하여 학습됨.

Feature assembly.

우리는 원본 2D feature와 우리의 fine-tuned feature를 concatenate함. 우리는 이것이 원본 2D feature extractor의 일반화 능력을 보존하면서 우리의 fine-tuned feature에 3D awareness를 통합하는 데 핵심임을 관찰함. feature assembly에 대한 다양한 전략은 4.6절에서 평가됨.

4. Experiments

4.1. Datasets

Training.

우리는 feature Gaussian들을 ScanNet++ [65]에서 학습함.

이것은 서브밀리미터 해상도의 레이저 스캔, 등록된 DSLR 이미지, 그리고 iPhone의 상용 RGB-D 스트림을 포함하는 대규모 3D 실내 scene 데이터셋임.

우리는 140451개의 view를 포함하는 230개 scene의 공식 training split으로 학습함.

Evaluation.

fine-tuned feature들의 효과를 검증하기 위해, 우리는 semantic segmentation과 depth estimation을 포함한 downstream 2D task들에 대한 광범위한 실험을 수행함.

우리 연구에는 직접적인 경쟁자가 없으며, 대신 우리의 3D-aware fine-tuning이 표준 2D feature extractor와 비교하여 성능 향상을 가져올 수 있는지에 초점을 맞춤.

우리는 대부분의 실험을 DINOv2 [44]로 수행하는 한편, 4.5절에서 다른 vision model들을 사용하여 우리 접근법의 보편성을 또한 입증함.

우리는 먼저 50개의 scene과 30638개의 이미지를 포함하는 ScanNet++ [65] validation set에서 평가함.

그 다음, 우리는 ScanNet++와 유사한 데이터 분포를 가지지만 다른 센서로 촬영된 다른 실내 데이터셋인 ScanNet [9]과 NYUv2 [55]로 넘어감.

fine-tuned feature들의 일반화 능력을 조사하기 위해, 우리는 또한 ADE20k [67], Pascal VOC [17] 그리고 실외 데이터셋인 KITTI [19]를 포함한 일반적으로 분포된 데이터셋에 대한 out-of-domain 평가를 수행함.

4.2 Implementation Details

Feature Gaussians.

우리는 feature rasterization을 위해 custom CUDA kernel들을 작성함.

각 Gaussian은 64차원의 무작위 feature vector로 초기화됨.

우리는 3x3의 kernel size를 가진 단일 convolutional layer로 up-projecting CNN을 구현함.

우리는 각 scene의 feature Gaussian들을 novel view synthesis와 feature rendering을 위해 30000 iteration 동안 공동으로 학습함.

✅ 1) “custom CUDA kernel을 작성함” → 무슨 의미?

기존 PyTorch 연산으로는 Gaussian feature rasterization이 너무 느리기 때문에,

저자들이 직접 CUDA 커널(저수준 GPU 연산 코드)을 구현했다는 뜻임.

즉,

- Gaussian들을 화면(pixels) 위에 뿌려서(feature rasterization)

- 2D feature map을 만드는 과정

이 부분을 고속 GPU 코드로 직접 구현했다는 의미.

➡️ 속도 때문에 custom CUDA 필요했다는 뜻.

✅ 2) “각 Gaussian은 64차원의 무작위 feature vector로 초기화됨”

초기에는 3D Gaussian마다 64-dimensional feature vector f를 아무 정보 없는 random 값으로 넣어둠.

이 값을 나중에 training을 통해:

- multi-view 2D foundation feature로부터

- 실제 의미 있는 3D-aware feature로 업데이트함

즉, 처음에는 랜덤이고 → training으로 의미 있는 feature가 됨.

✅ 3) “3×3 kernel의 단일 convolution layer로 up-projecting CNN을 구현함”

Gaussian에 저장된 feature는 **저차원(64D)**이기 때문에

렌더링 후 **원래 DINO의 고차원 feature(384D)**로 되돌리는 up-projection 단계가 필요함.

이를 위해:

- 굉장히 가벼운 CNN 하나만 사용

(3×3 conv 1 layer → 매우 작은 네트워크)

즉,

저차원 feature map FlowF^{low} → up-project → 고차원 feature map FhighF^{high}

이 역할을 하는 작은 디코더를 사용했다는 뜻.

➡️ 속도·메모리 절약이 목표.

✅ 4) “각 scene의 feature Gaussian들을 novel view synthesis와 feature rendering을 위해 30,000 iteration 동안 공동으로 학습함”

한 scene의 Gaussian들을 학습하는 과정은 다음 두 가지 목적을 동시에 최적화함:

- novel view synthesis

→ RGB reconstruction loss 기반 (원래 Gaussian splatting의 photometric loss) - feature rendering

→ DINO feature consistency 유지 (multi-view feature distillation loss)

즉,

RGB 색상도 잘 재현하고,

동시에 멀티뷰 feature도 정확히 재현하도록

→ Gaussians의 위치·scale·opacity·feature vector 등을 30,000번 iteration으로 최적화함.

➡ 결국 각 scene은 30k iteration의 training을 거쳐 “3D-aware Gaussian representation”이 학습됨.

Fine-tuning.

우리는 384의 feature dimension을 가진 DINOv2 small을 batch size 2, learning rate 1e-5로 1 epoch 동안 fine-tune함.

우리는 data augmentation으로 horizontal flip을 사용함.

우리는 1e-4의 weight decay factor를 가진 AdamW [40] optimizer를 사용함. 단일 Nvidia Tesla A100에서의 fine-tuning은 8.5시간이 소요됨.

Linear probing.

우리는 공정한 비교를 보장하기 위해 DINOv2 [44]의 linear probing protocol을 따름.

semantic segmentation의 경우, 우리는 8개의 GPU로 40K iteration 동안 linear layer를 학습함.

depth estimation의 경우, 우리는 8개의 GPU로 38400 iteration 동안 linear layer를 학습함.

추가적으로, 우리는 DINOv2와 동일한 data augmentation과 learning rate schedule을 사용함.

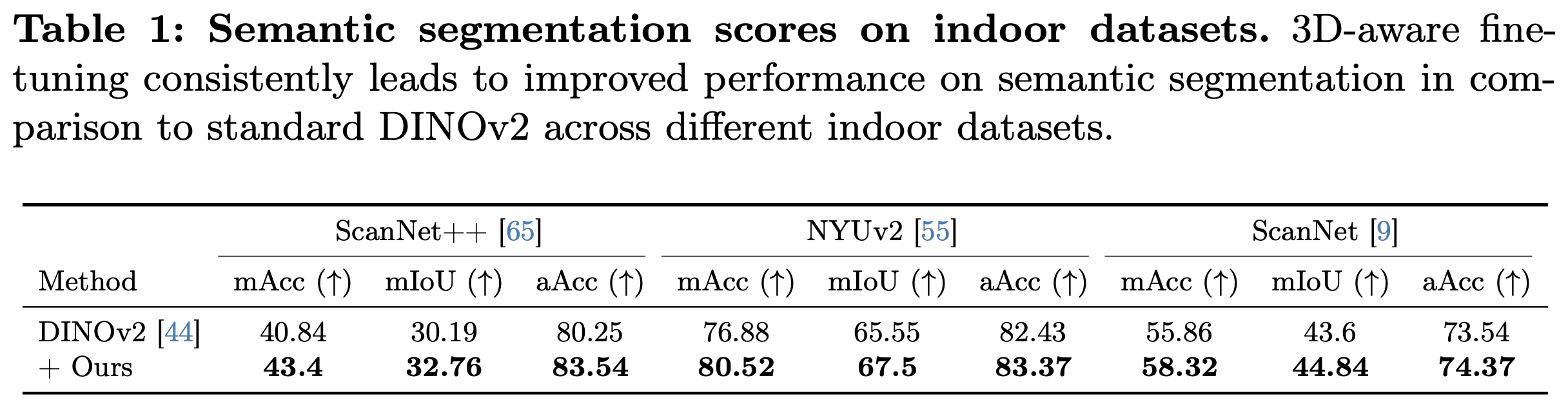

4.3. Within-domain Evaluation

Quantitative comparison.

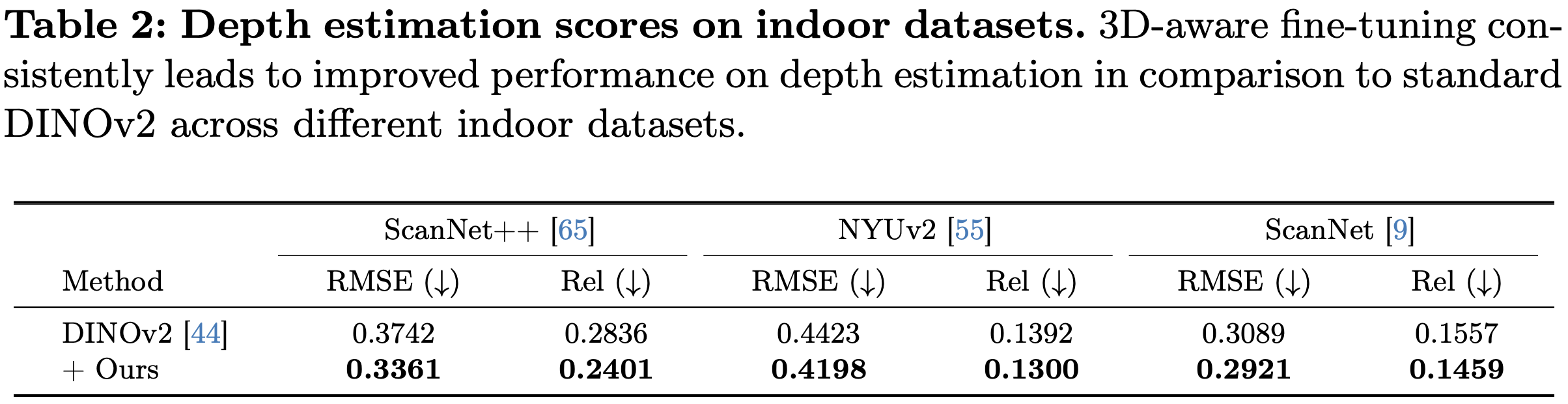

우리는 실내 scene에 대한 downstream semantic segmentation (표 1 참조) 및 depth estimation task (표 2 참조)에서 우리의 3D-aware feature를 통합하는 것의 효과를 입증함.

- semantic segmentation task의 경우, 우리의 3D aware feature들은 DINOv2 feature들을 일관되게 개선하며, ScanNet++ [65], NYUv2 [55] 및 ScanNet [9] 데이터셋에서 각각 2.6%, 2.0% mIoU, 그리고 1.2%의 상당한 성능 향상을 달성함.

- 우리의 3D-aware DINOv2 feature들은 depth estimation task에서도 성능을 향상시킴.

특히, 우리의 향상된 feature들은 ScanNet++ [65]에서 0.34 대 0.37 (DINOv2), NYUv2 [55]에서 0.42 대 0.44 (DINOv2), 그리고 ScanNet [9] 데이터셋에서 0.29 대 0.31 (DINOv2)을 달성함으로써 데이터셋 전반에 걸쳐 RMSE를 일관되게 감소시킴.

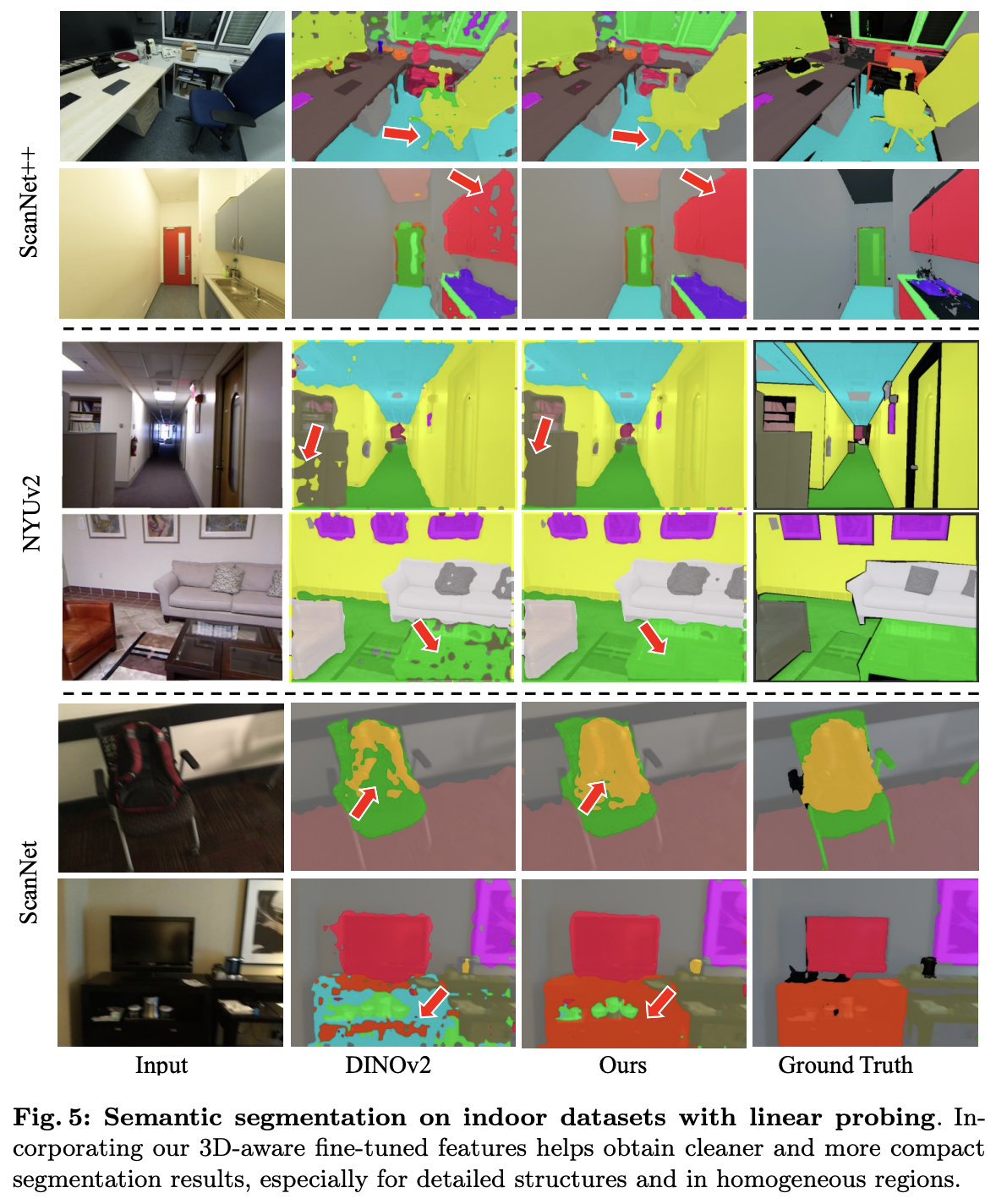

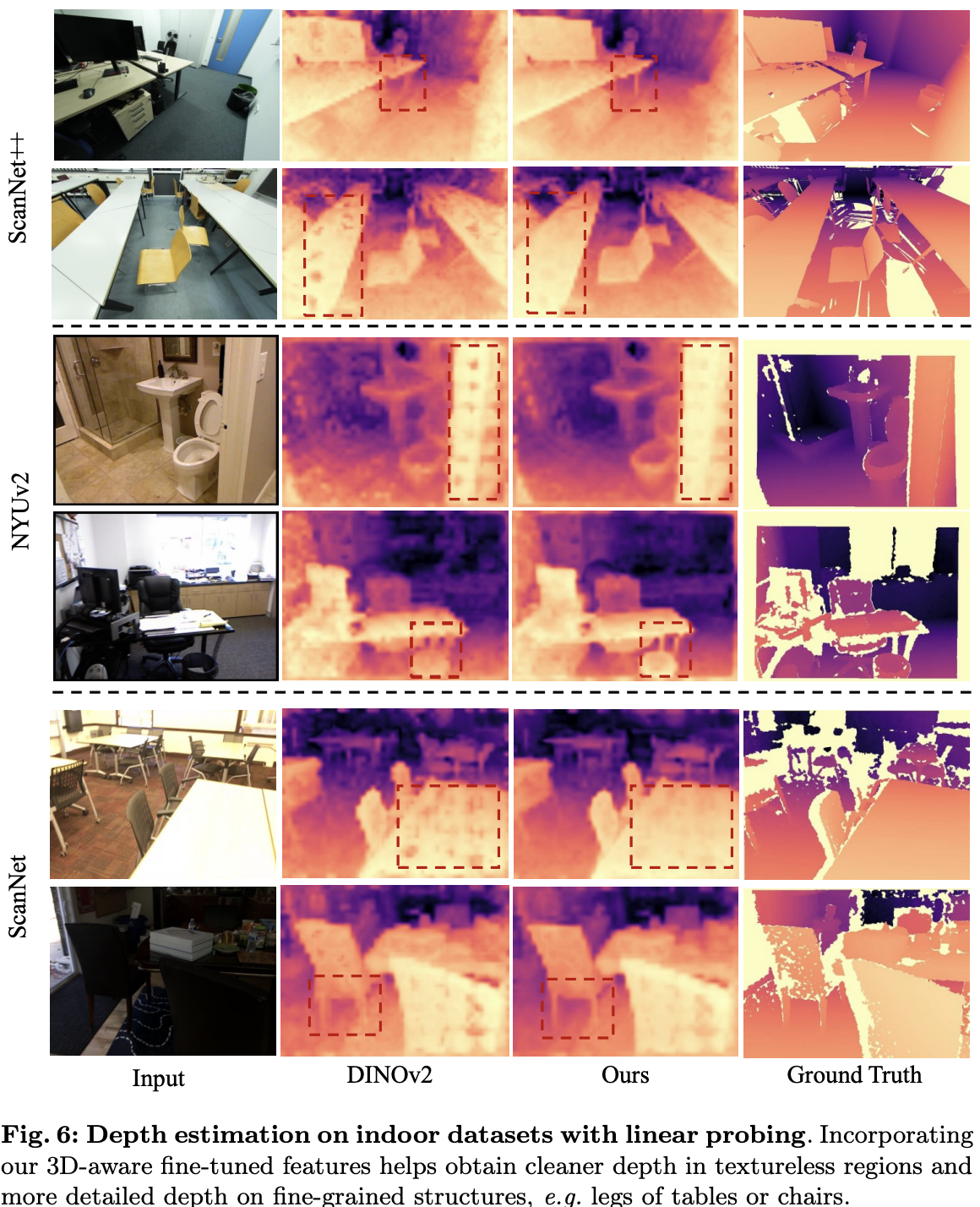

Qualitative comparison.

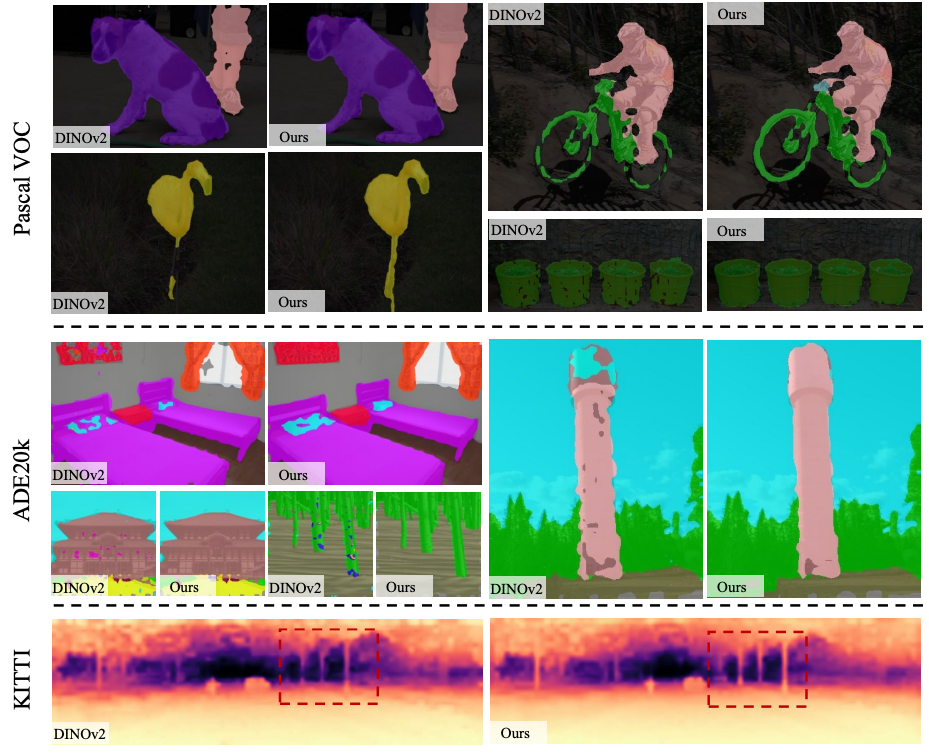

우리는 그림 5와 그림 6에서 3D-aware feature들의 이점을 정성적으로 보여줌.

우리는 개선 사항이 주로 두 가지 측면에서 나타나는 것을 관찰함:

(1) 벽이나 보드와 같은 균일하거나(homogeneous) 질감이 없는(textureless) 영역에서 더 깨끗한 segmentation/depth estimation, 그리고

(2) 의자나 테이블 다리와 같은 미세한(fine-grained) 디테일에 대한 더 나은 예측.

(1)에 대해, 2D feature를 3D로 lifting하는 동안, 여러 view의 feature들이 전체적인(holistic) representation으로 집계되므로, 한 view의 정보가 암묵적으로 다른 view들을 보완함.

우리는 이러한 multi-view awareness가 fine-tuning을 통해 DINOv2로 전달된다고 가정함.

대조적으로, 표준 DINOv2는 모호성이 있을 때 단일 이미지로부터 정확한 segmentation이나 depth를 추론하는 데 어려움을 겪으며, 따라서 노이즈가 많은 예측으로 이어짐.

(2)에 대해, 우리의 feature lifting 과정에서, 우리는 RGB color를 supervision으로 사용하여 Gaussian들의 geometry 속성(예: 위치 및 불투명도)을 학습함.

RGB guidance는 feature Gaussian들이 상세한 3D 구조를 배우고 고해상도 feature map을 렌더링하는 데 도움을 줌 (그림 1 (c) 참조). fine-tuning 과정 동안, 모델은 객체의 미세한(fine-grained) feature들을 추정하는 법을 배우며 (그림 1 (d) 대 (b) 참조), 이는 downstream task에서 상세한 구조를 포착하는 데 도움이 됨.

4.4 Out-of-domain Evaluation

우리는 feature Gaussian을 학습하고 DINOv2를 오직 테이블, 의자 및 기타 실내 가구와 같은 일반적인 콘텐츠를 포함하는 실내 scene 데이터셋인 ScanNet++에서만 fine-tune함.

우리는 이 설정에서 얻은 이득이 실외 scene과 같은 다른 domain으로 어떻게 일반화되는지 분석하고자 함.

- semantic segmentation의 경우, 우리는 ADE20k [67]와 Pascal VOC [17]에서 linear probing을 수행함.

- depth estimation의 경우, 우리는 KITTI [19]에서 linear probing을 수행함.

Quantitative comparison.

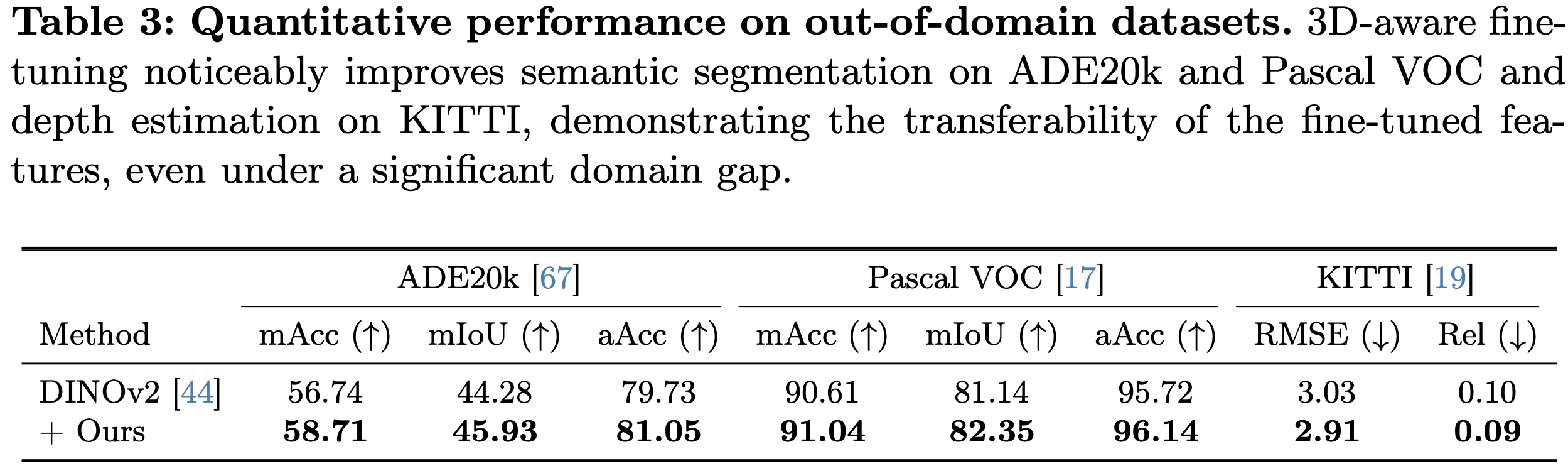

우리는 3D-aware feature에 의해 가져온 개선점이, 비록 더 작은 정도이기는 하지만, out-of-domain의 까다로운 데이터셋과 실외 주행 scene으로도 일반화 가능함을 관찰함.

표 3에서 보여주듯이, semantic segmentation task의 경우, 우리의 3D-aware feature를 통합하는 것은 표준 DINOv2 feature에 비해 ADE20k [67]에서 1.6% mIoU의 이득을, Pascal VOC [17]에서 1.2% mIoU의 이득을 가져옴. 더욱이, 우리는 depth estimation을 위해 도시 scene 데이터셋인 KITTI [19]에서의 우리의 성능 또한 비교하며, 우리의 3D-aware feature가 RMSE를 3.03 (DINOv2)에서 2.91로 줄이는 데 도움을 주는 것을 관찰함.

Qualitative comparison.

우리는 그림 7에서 out-of-domain 데이터셋에 대한 정성적 비교를 보여줌.

우리는 within-domain 데이터셋에서와 유사한 개선 사항을 관찰함.

비록 3D-aware fine-tuning이 실내 데이터셋인 ScanNet++에서만 수행되었음에도 불구하고, fine-tune된 feature들은 자전거와 동물 같은 흔한 객체들의 상세한 구조에 대한 segmentation 결과를 개선하는 전이성(transferability)을 보이며, 나무, 건물, 기둥과 같은 객체들의 더 조밀한(compact) segmentation을 달성하는 데 도움을 줌.

depth estimation에서는, 통합된 3D-aware feature들이 나무의 상세한 구조를 포착하는 데 도움이 됨.

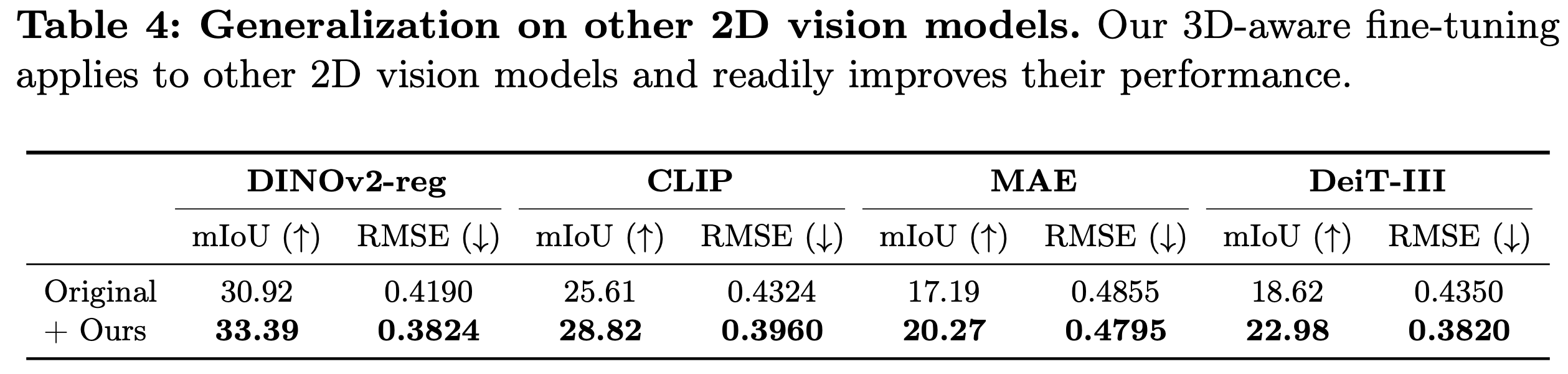

4.5 Universality of Our Approach

우리는 우리의 3D-aware fine-tuning을 다른 2D 시각 모델에 적용함으로써 우리 접근법의 보편성을 입증함.

특히, 우리는 DINOv2-reg [44] (register token을 사용한 ViT-S), CLIP [48] (ViT-B), MAE [26] (ViT-L) 그리고 DeiT-III [58] (ViT-L)에 대해 테스트함.

우리는 ScanNet++ [65]에서 semantic segmentation과 depth estimation task에 대한 이 모델들의 성능을 평가함.

표 4에서 보여주듯이, 우리의 3D-aware feature들은 다른 downstream task에서 다른 모델들의 성능을 향상시키는 데 보편적으로 도움이 됨.

이러한 결과들은 우리 방법이 광범위한 모델들에 대해 일반화됨을 입증하며, 2D 시각적 representation을 향상시키기 위한 plug-and-play 모듈이 될 잠재력이 있음을 보여줌.

4.6 Ablation Studies and Analysis

이 섹션에서, 우리는 몇 가지 ablation study를 수행하고 우리 방법에 대한 더 상세한 분석을 제공함.

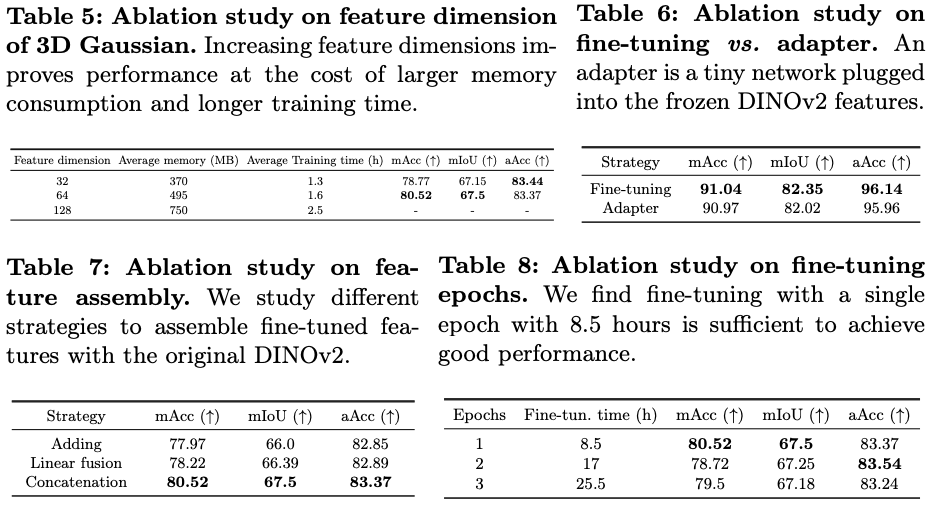

Feature dimension of each Gaussian.

우리는 ScanNet++ [65]에서 feature dimension D가 우리 접근법의 성능에 미치는 영향을 연구함.

표 5에서 보여주듯이, 우리 방법의 성능은 feature Gaussian의 feature dimension에 민감함.

전체 384차원 DINOv2 feature를 lifting하는 것은 큰 메모리 소비 때문에 우리 하드웨어에서는 실행 불가능함.

우리는 모델 성능, 메모리 소비, 그리고 학습 시간 사이의 좋은 절충안으로서 64의 feature dimension을 선택했음.

Feature assembly strategy.

우리는 표 7에서 fine-tune된 feature들을 원본 DINOv2 feature들과 조립하는(assemble) 다른 전략들을 연구함.

우리는 간단한 channel-wise 덧셈과 concatenation을 탐색함.

대안으로, 우리는 먼저 fine-tune된 feature들을 원본 DINOv2 feature들과 concatenate한 다음, linear layer를 사용하여 그것들을 DINOv2의 동일한 feature space로 융합(fuse)함.

우리는 간단한 concatenation이 학습된 3D-aware feature들을 통합하면서 원본의 일반화 능력을 보존하는 데 잘 작동함을 관찰함.

Fine-tuning epochs.

우리는 사전 학습된 feature Gaussian에 의해 렌더링된 feature들을 사용하여 DINOv2를 fine-tune함.

표 8은 단일 epoch이 3D awareness를 DINOv2로 전달하기에 충분하며, 더 많은 epoch은 모델의 일반화 능력을 해칠 수 있음을 시사함.

Fine-tuning vs. adapter.

DINOv2를 직접 fine-tuning하는 것 외에, 우리는 DINOv2를 고정(frozen)시키고 그 위에 adapter를 도입하는 대안 전략을 탐색함. adapter는 단일 Swin Transformer 블록 [39]임.

우리는 adapter가 도움이 되지만, 우리 실험에서는 fine-tuning이 더 잘 작동함을 관찰함.

Limitations and discussion.

우리 연구는 3D Gaussian representation에 의해 인코딩된 multi-view consistent하고 3D-aware한 feature들을 fine-tuning을 통해 2D foundation model로 전달하는 첫 걸음을 내디딤.

우리는 3D-aware feature들이 downstream task에 도움이 됨을 입증함.

그러나, 우리는 일반화 능력을 유지하기 위해 여전히 원본 feature들을 필요로 함.

우리는 이것을 우리의 3D 학습 데이터의 제한된 다양성(단 하나의 실내 데이터셋) 탓으로 돌리며, 이것이 더 큰 규모의 데이터에 대한 fine-tuning으로 해결될 수 있다고 가정함.

5. Conclusion

본 연구에서, 우리는 2D foundation model에 3D awareness를 주입하는 방법을 제시함.

우리는 먼저 2D foundation feature들을 3D Gaussian representation으로 lift한 다음, 렌더링된 multi-view consistent하고 3D-aware한 feature들을 사용하여 역으로 2D foundation model을 fine-tune함.

우리의 실험들은 fine-tuned feature들을 통합하는 것이 간단한 linear probing을 통해 semantic 및 geometric task 모두에서 즉시 성능 향상으로 이어진다는 것을 보여줌.

비록 우리는 3D-aware fine-tuning을 단일 데이터셋 ScanNet++에서만 수행했지만, 우리는 학습된 3D awareness가 다른 domain의 다양한 데이터셋에 걸쳐 전이 가능함을 입증함.

우리는 우리 연구가 향후 2D foundation model에 3D-aware understanding을 갖추는 것을 고려하는 연구에 영감을 주기를 바람.